ChatGPT开发大语言模型需要什么?

关键一:数据 训练数据主要是所谓的语料库。今天的很多语言模型的语料库主要有以下几种: Books:BookCorpus 是之前小语言模型如 GPT-2 常用的数据集,包括超过 11000 本电子书。主要包括小说和传记,最近更新时间是 20...

关键一:数据 训练数据主要是所谓的语料库。今天的很多语言模型的语料库主要有以下几种: Books:BookCorpus 是之前小语言模型如 GPT-2 常用的数据集,包括超过 11000 本电子书。主要包括小说和传记,最近更新时间是 20...

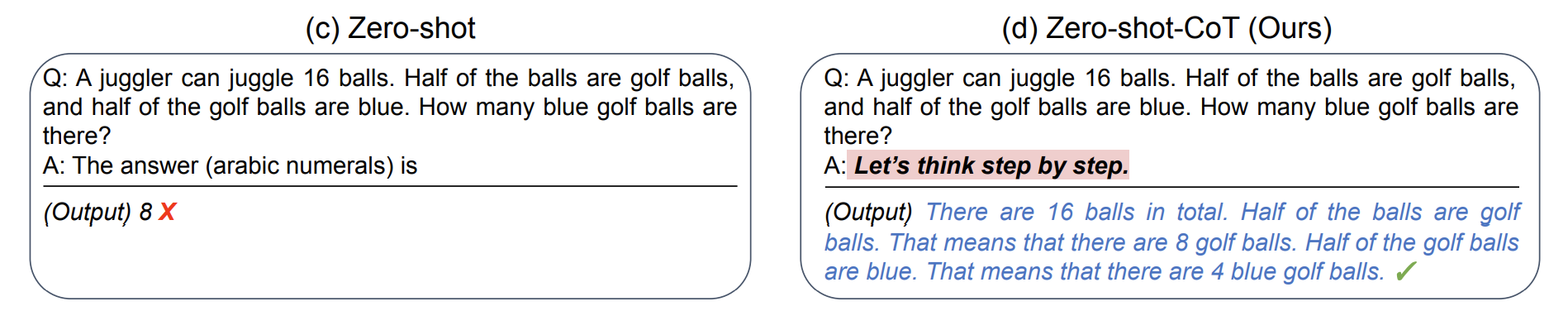

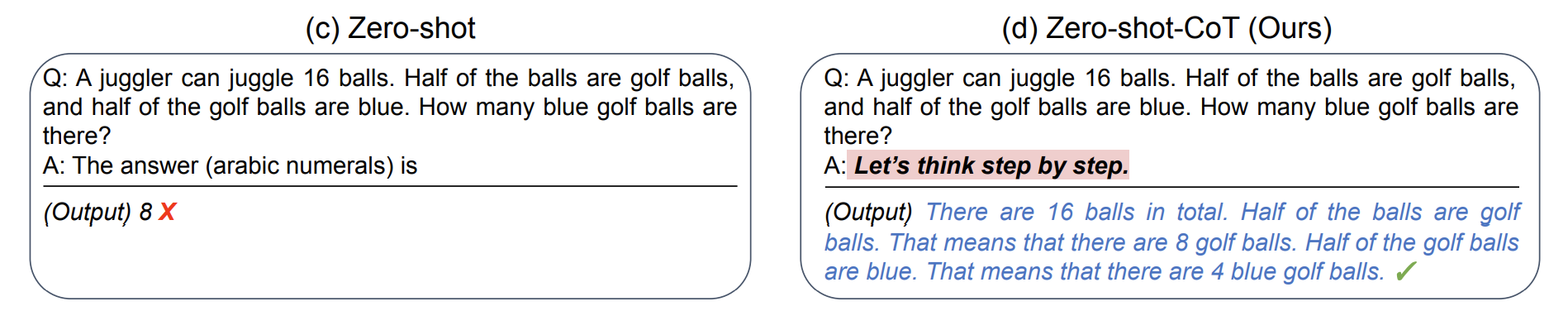

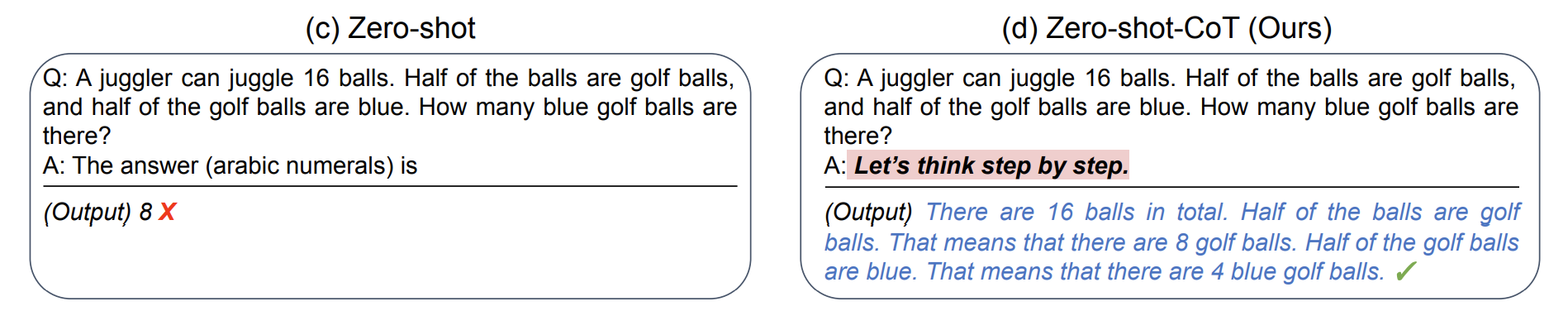

基于上述的第三点缺点,研究人员就找到了一个叫 Chain of Thought 的技巧。 这个技巧使用起来非常简单,只需要在问题的结尾里放一句 Let‘s think step by step (让我们一步步地思考),模型输出的答案会更加准...

缺点一:结果高度依赖训练语料 正如我前面提到的,当今的语言模型,即使发展了四个版本,但依然没有脱离「概率计算」,本质上来说它们的核心原理就是「利用已有的信息来预测其他信息」。 那这就意味着,大语言模型其实并没有意识,也不知道对错,其生成的...

假设你想让 AI 总结一篇非常非常长的文章,并且按照特定格式给你总结,那你可以在文章前面明确输出的格式(为了不占用太多显示空间,我省略了正文内容,你可以在 OpenAI 的 Playground 看到完整案例)。它的意思其实是让 ChatG...

基于上述的第三点缺点,研究人员就找到了一个叫 Chain of Thought 的技巧。 这个技巧使用起来非常简单,只需要在问题的结尾里放一句 Let‘s think step by step (让我们一步步地思考),模型输出的答案会更加准...

在示例里加入特定符号,让模型知道如何处理特殊情况 这个解释起来有点复杂,以下是 OpenAI 的官方 prompt,在一些奇怪的问题上比如 What is Devz9 的回答,你可以用 ? 代替答案,让模型知道当遇到超出回答范围时,需要如...

在示例里加入特定符号,让模型知道如何处理特殊情况 这个解释起来有点复杂,以下是 OpenAI 的官方 prompt,在一些奇怪的问题上比如 What is Devz9 的回答,你可以用 ? 代替答案,让模型知道当遇到超出回答范围时,需要如...

关键一:数据 训练数据主要是所谓的语料库。今天的很多语言模型的语料库主要有以下几种: Books:BookCorpus 是之前小语言模型如 GPT-2 常用的数据集,包括超过 11000 本电子书。主要包括小说和传记,最近更新时间是 20...

可以用“”“将指令和文本分开。根据我的测试,如果你的文本有多段,增加”“”会提升 AI 反馈的准确性(这个技巧来自于 OpenAI 的 API 最佳实践文档) 信息 感谢 CraneHuang6 的提醒,这里还能用 ### 符号区隔,不过我...

基于上述的第三点缺点,研究人员就找到了一个叫 Chain of Thought 的技巧。 这个技巧使用起来非常简单,只需要在问题的结尾里放一句 Let‘s think step by step (让我们一步步地思考),模型输出的答案会更加准...