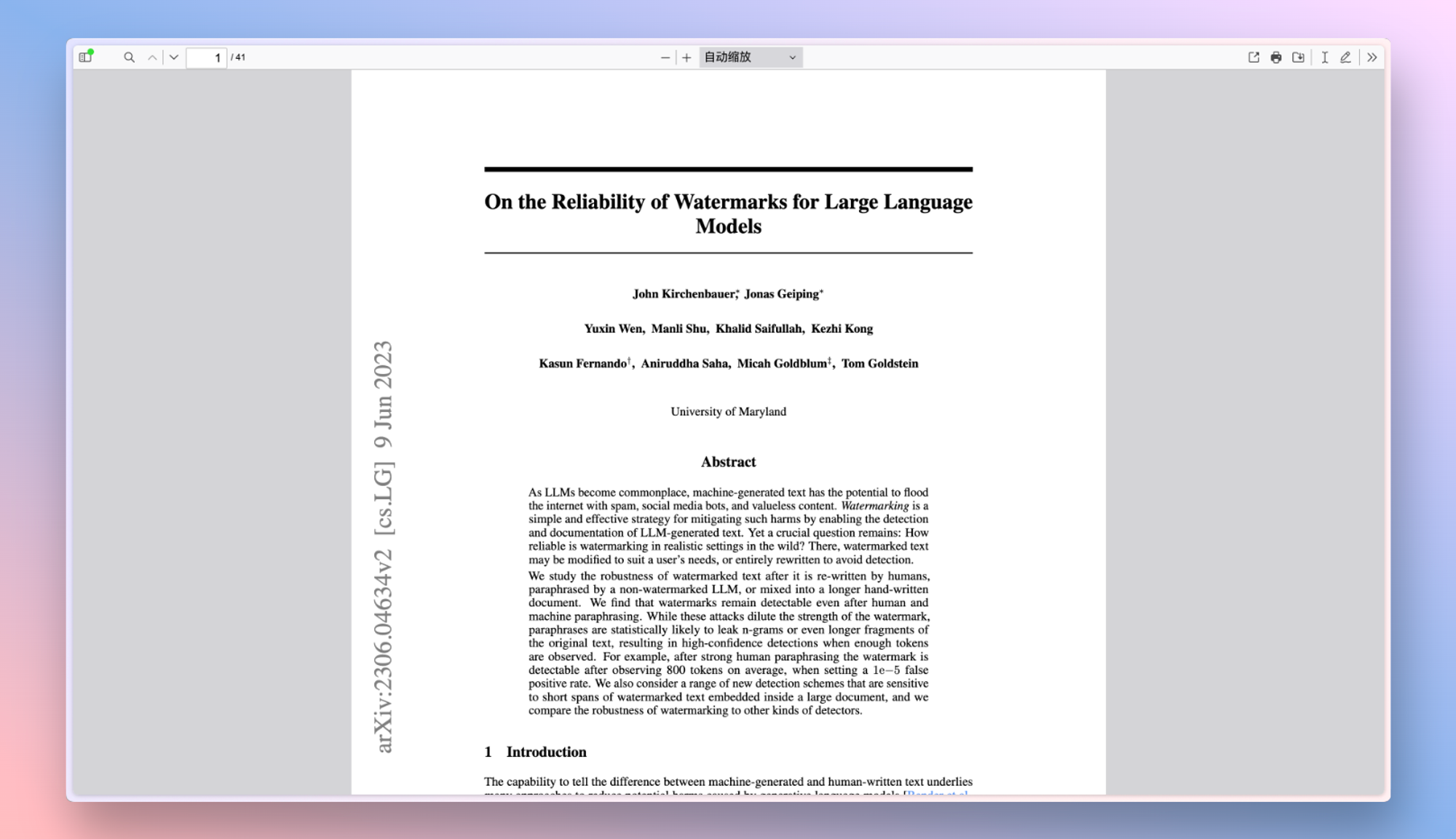

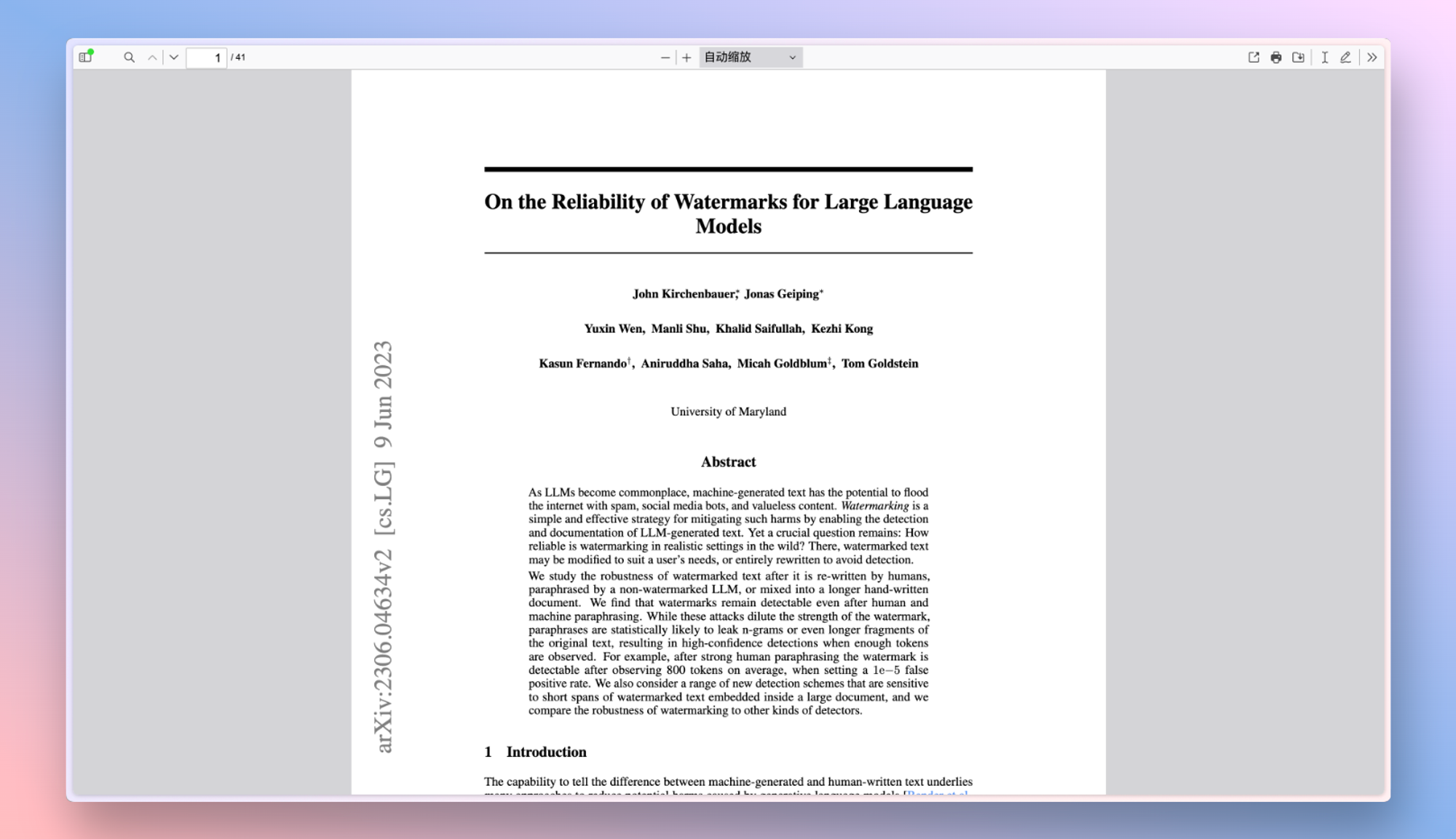

大型语言模型(LLMs)的水印可靠性问题。水印是一种简单有效的策略,可通过检测和记录LLM生成的文本来减轻垃圾邮件、社交媒体机器人和无价值内容等问题。本文研究了水印在现实环境中的鲁棒性,发现即使在人类和机器改写的情况下,水印仍然是可检测的。我们还比较了水印与其他检测器的鲁棒性,发现水印在样本复杂度方面更具优势。

大型语言模型(LLMs)的水印可靠性问题。水印是一种简单有效的策略,可通过检测和记录LLM生成的文本来减轻垃圾邮件、社交媒体机器人和无价值内容等问题。本文研究了水印在现实环境中的鲁棒性,发现即使在人类和机器改写的情况下,水印仍然是可检测的。我们还比较了水印与其他检测器的鲁棒性,发现水印在样本复杂度方面更具优势。

RinCoin 是一种基于比特币核心 (Bitcoin Core) 的去中心化数字货币,它引入了一种名为RinHash 的全新工作量证明 (PoW) 哈希算法

RinCoin 是一种基于比特币核心 (Bitcoin Core) 的去中心化数字货币,它引入了一种名为RinHash 的全新工作量证明 (PoW) 哈希算法 Unichain 测试网水龙头信息

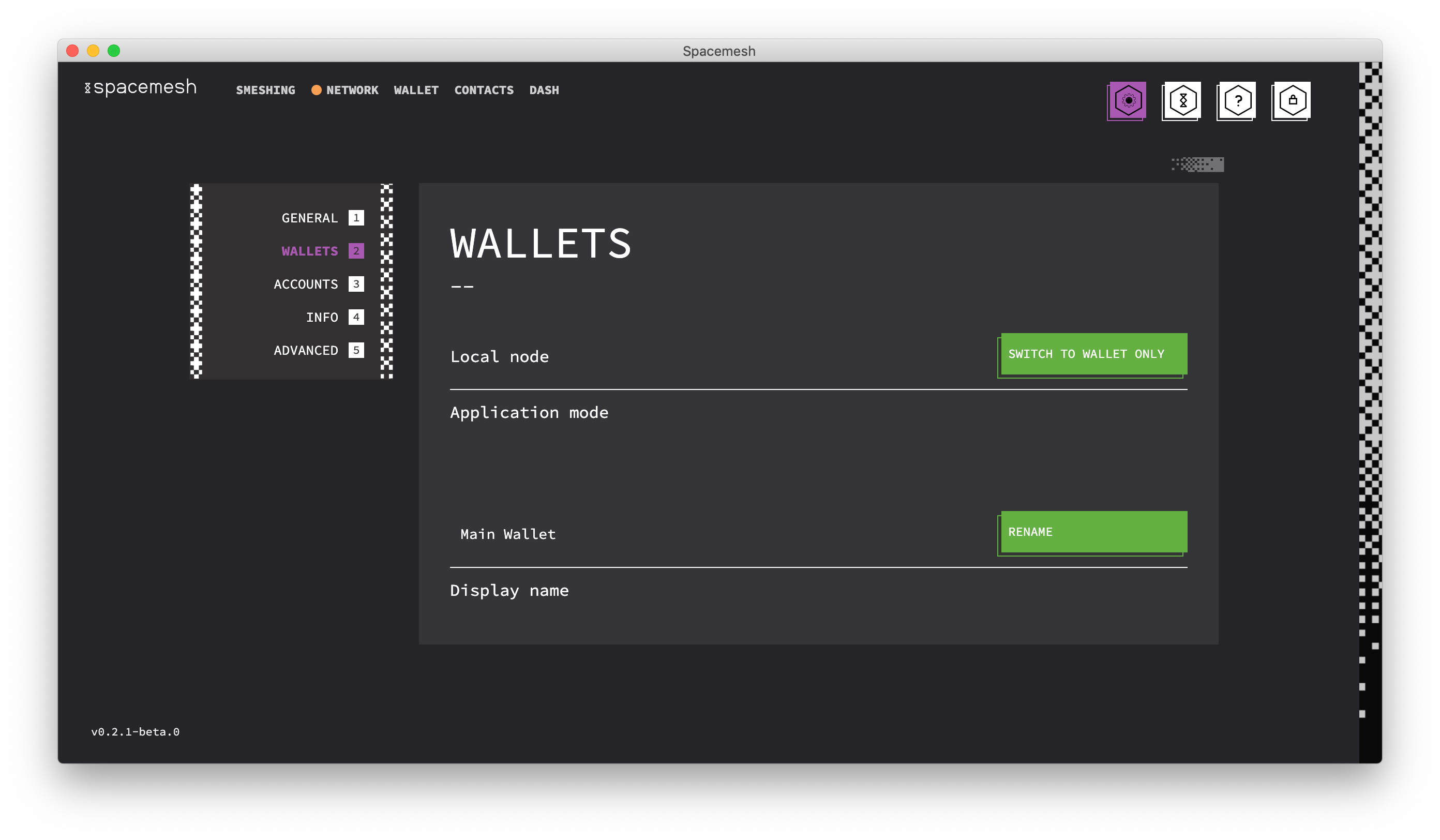

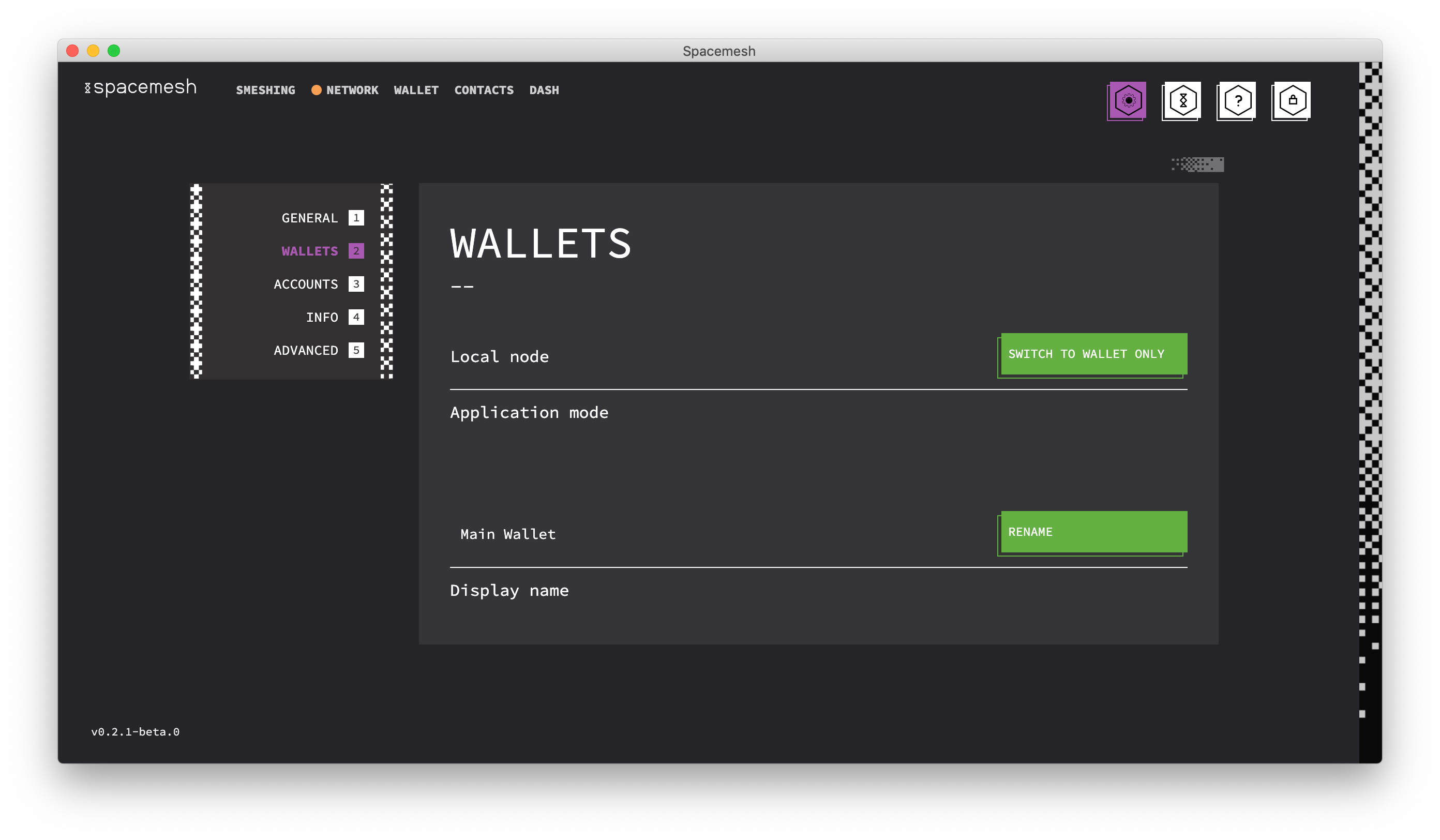

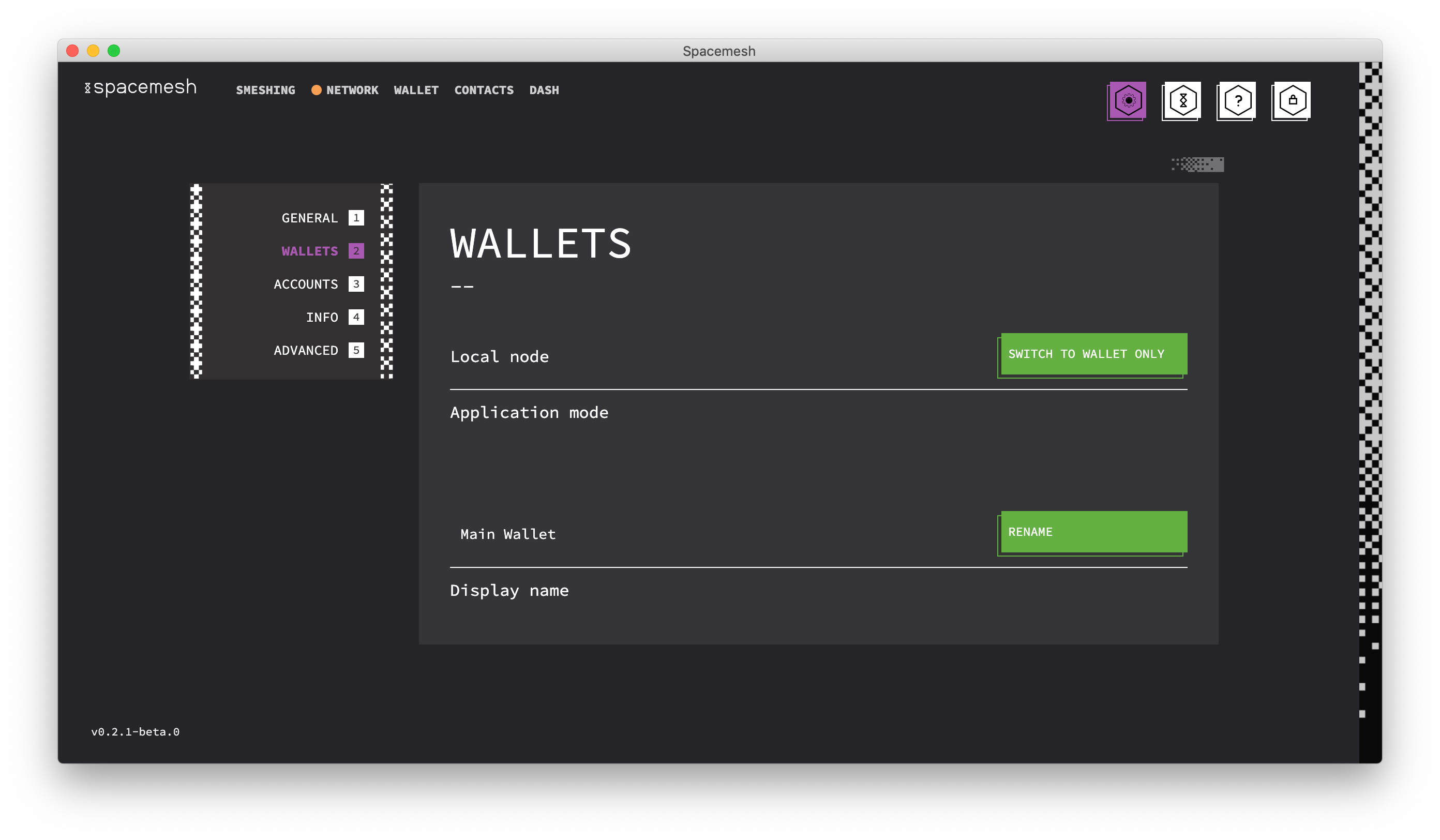

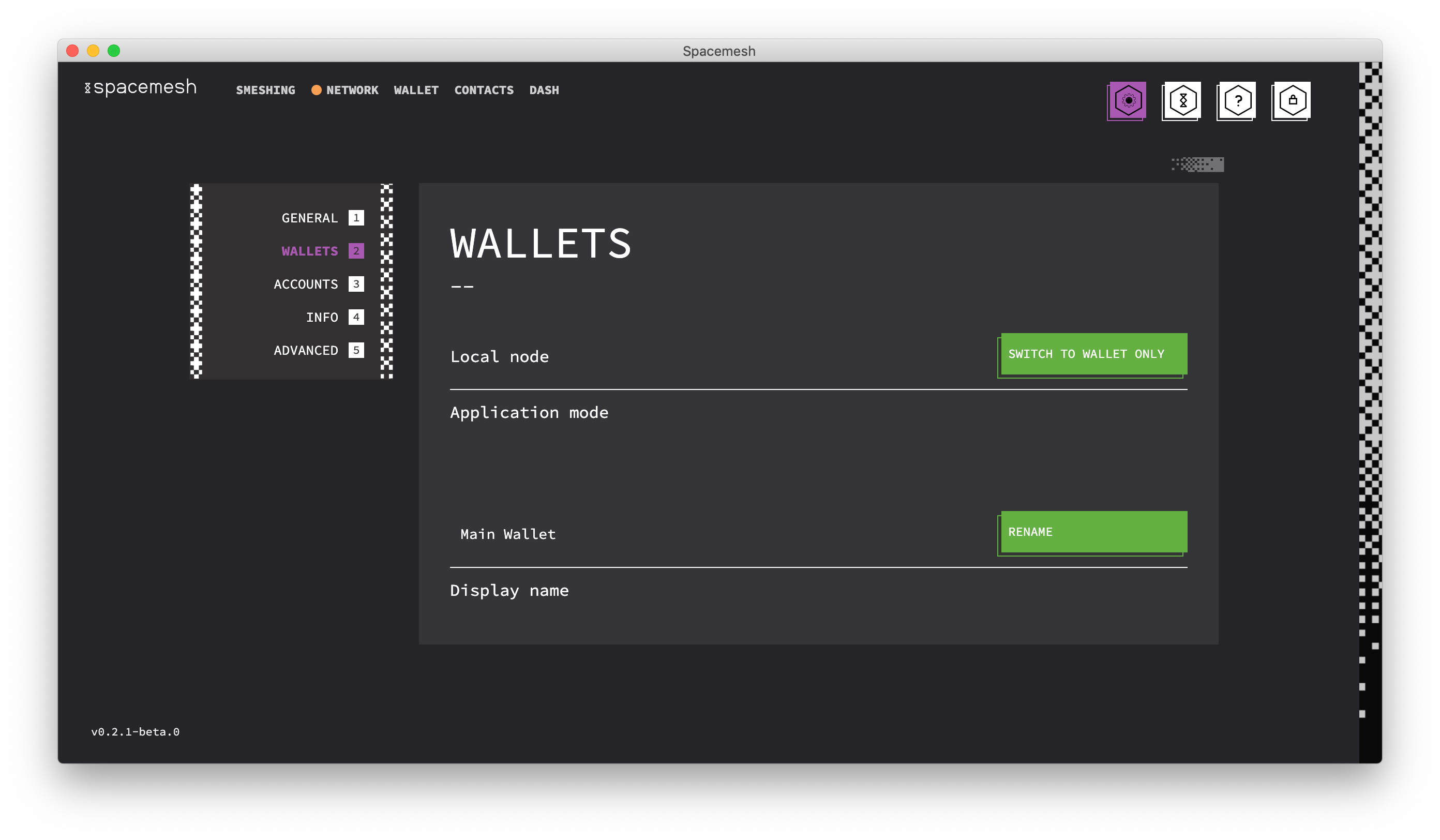

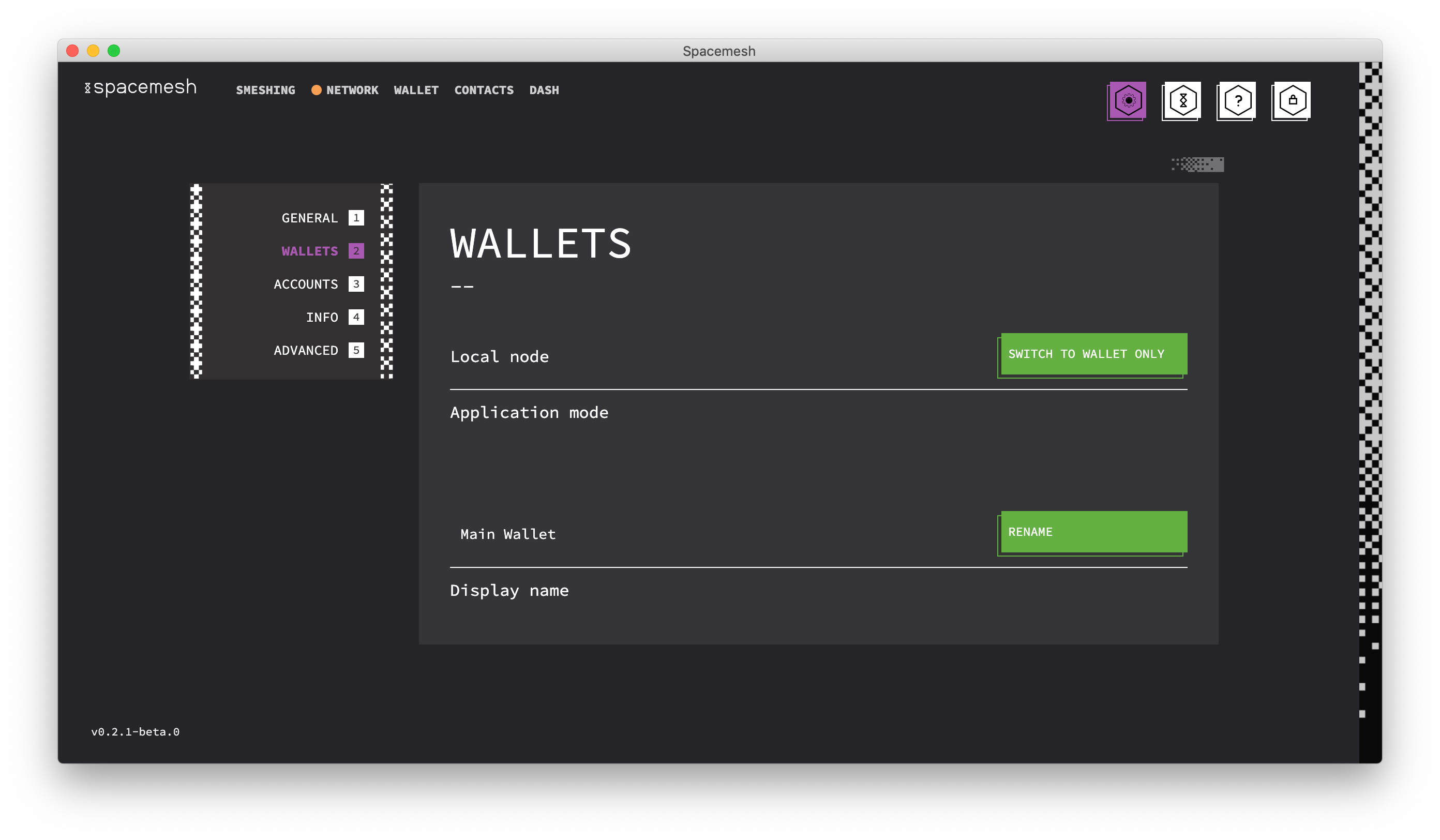

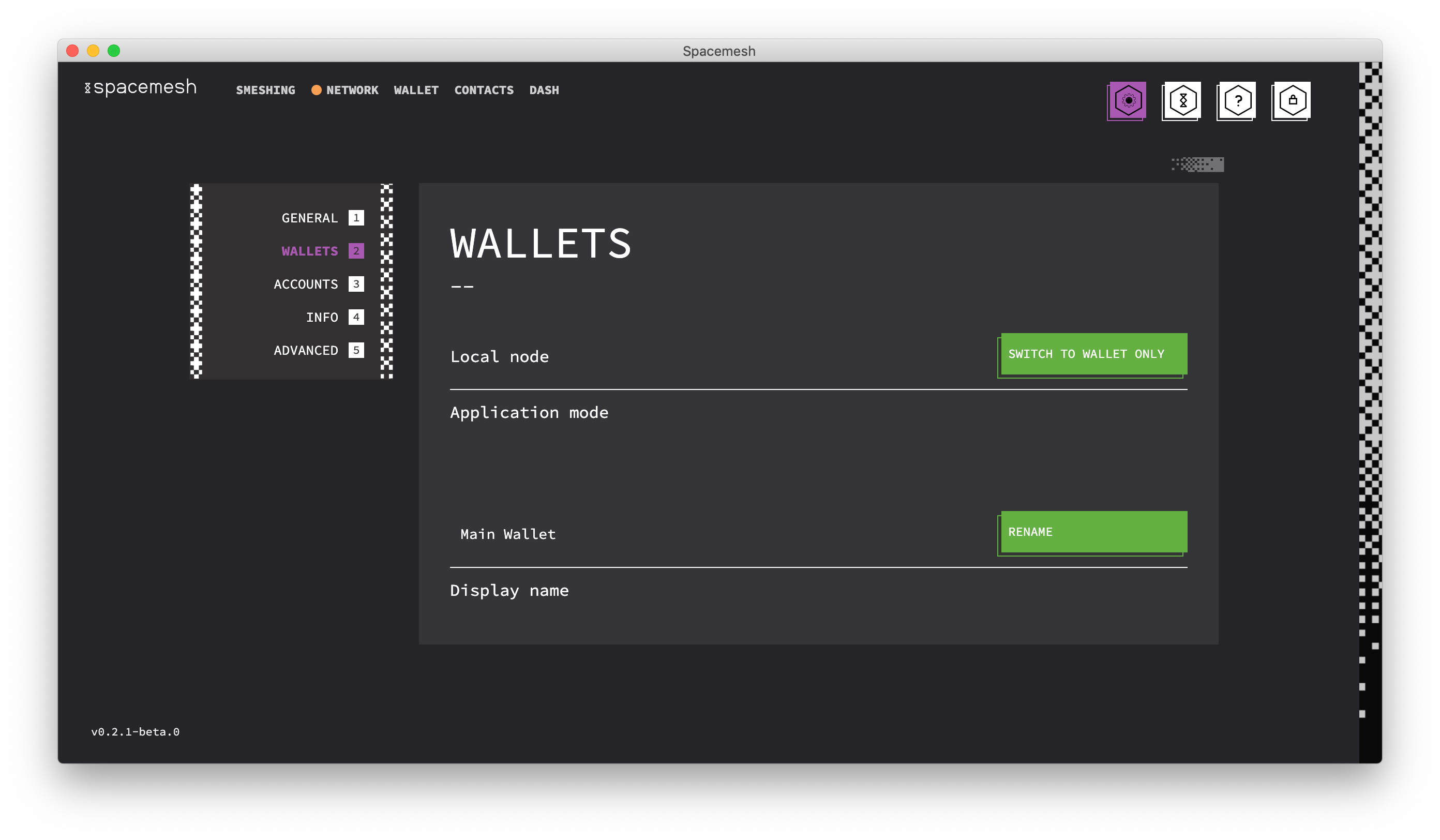

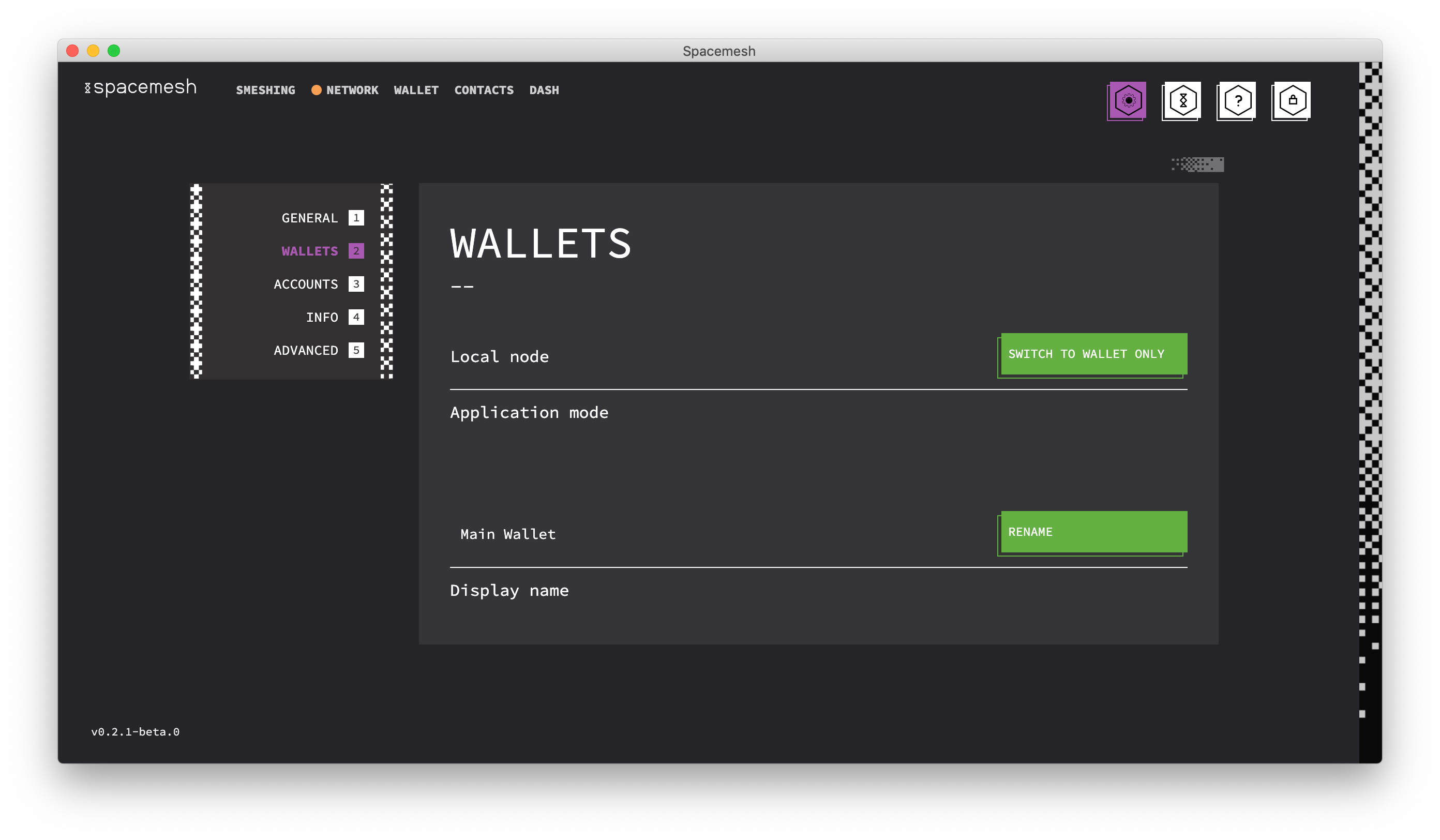

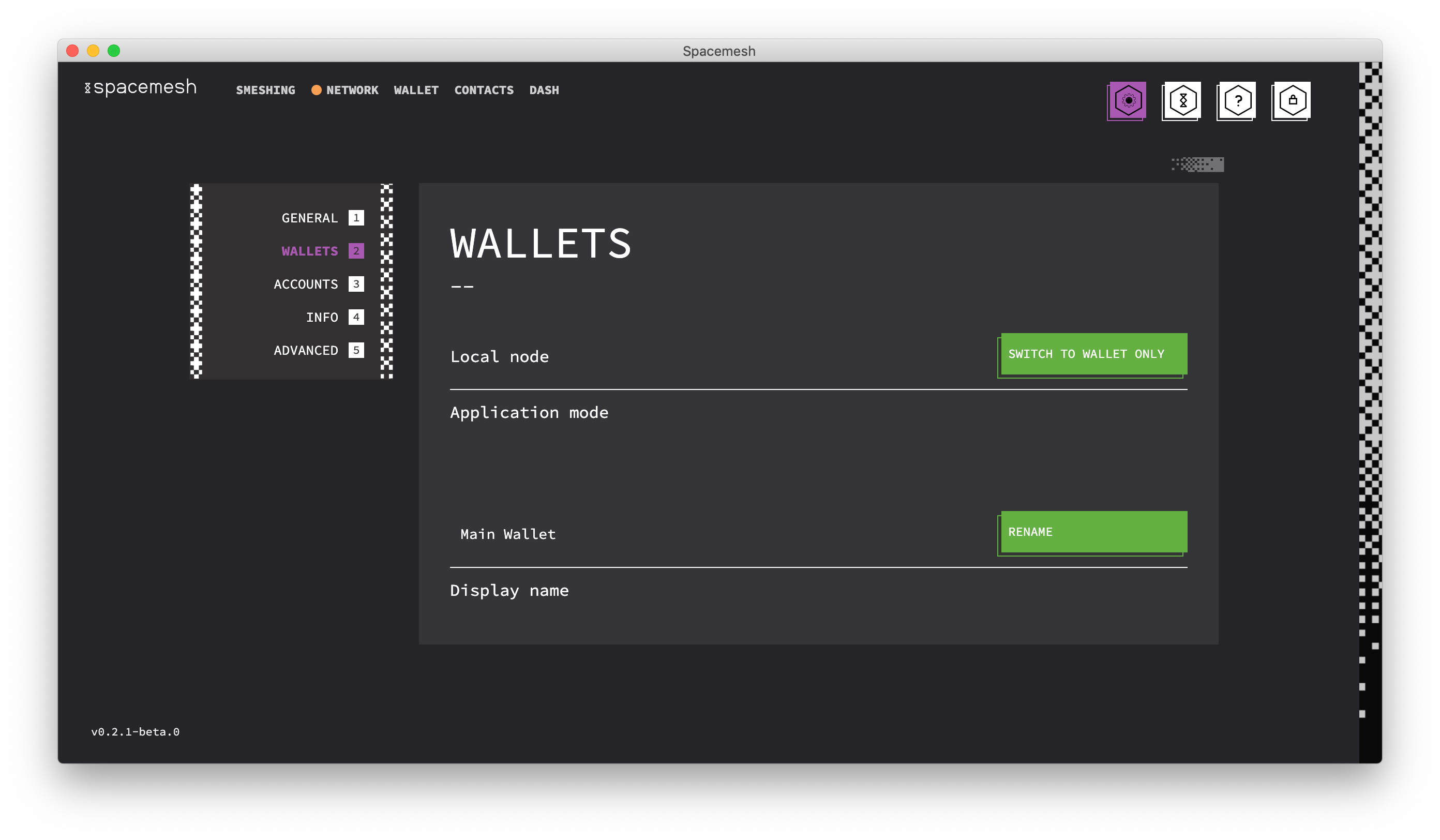

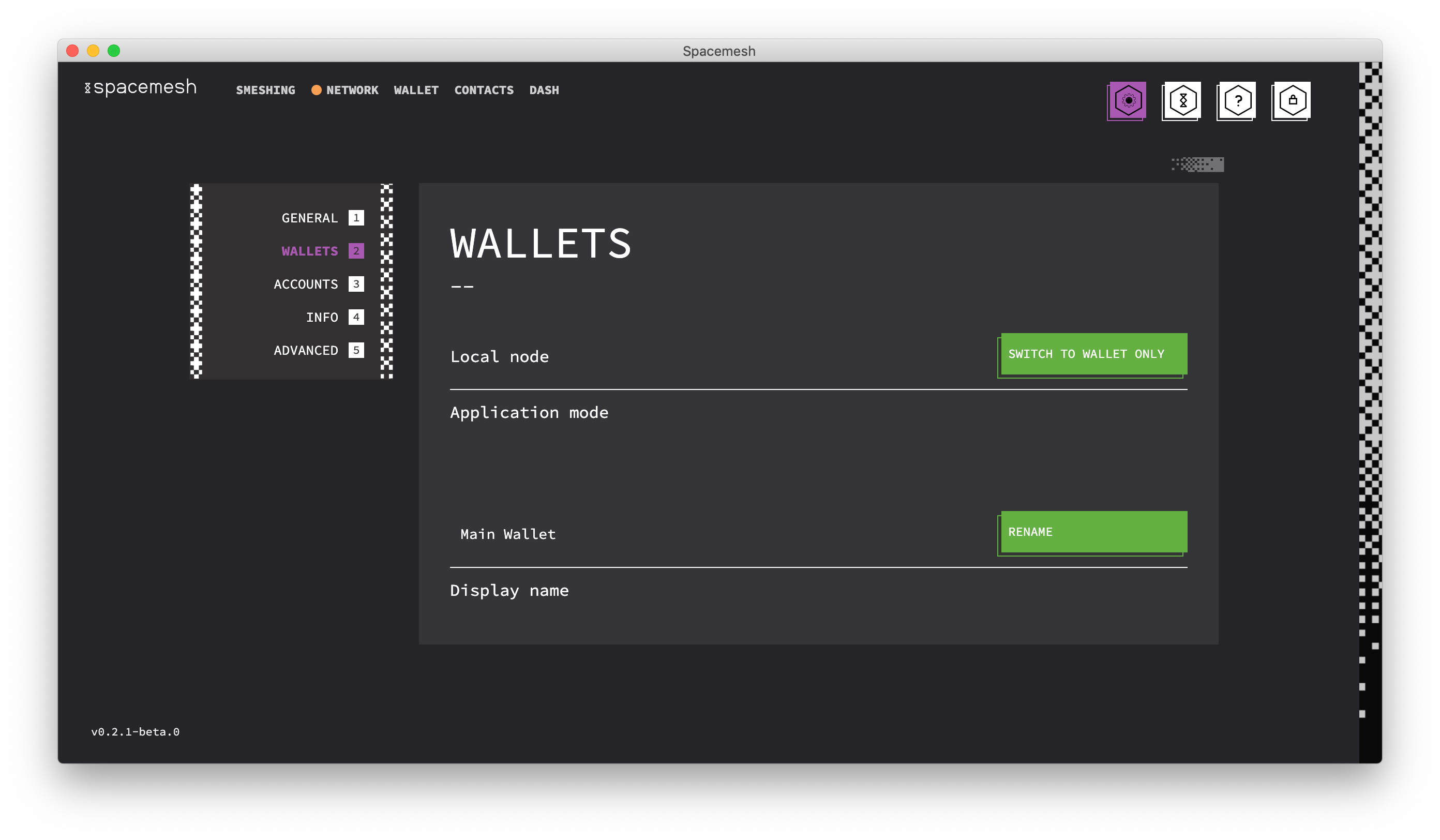

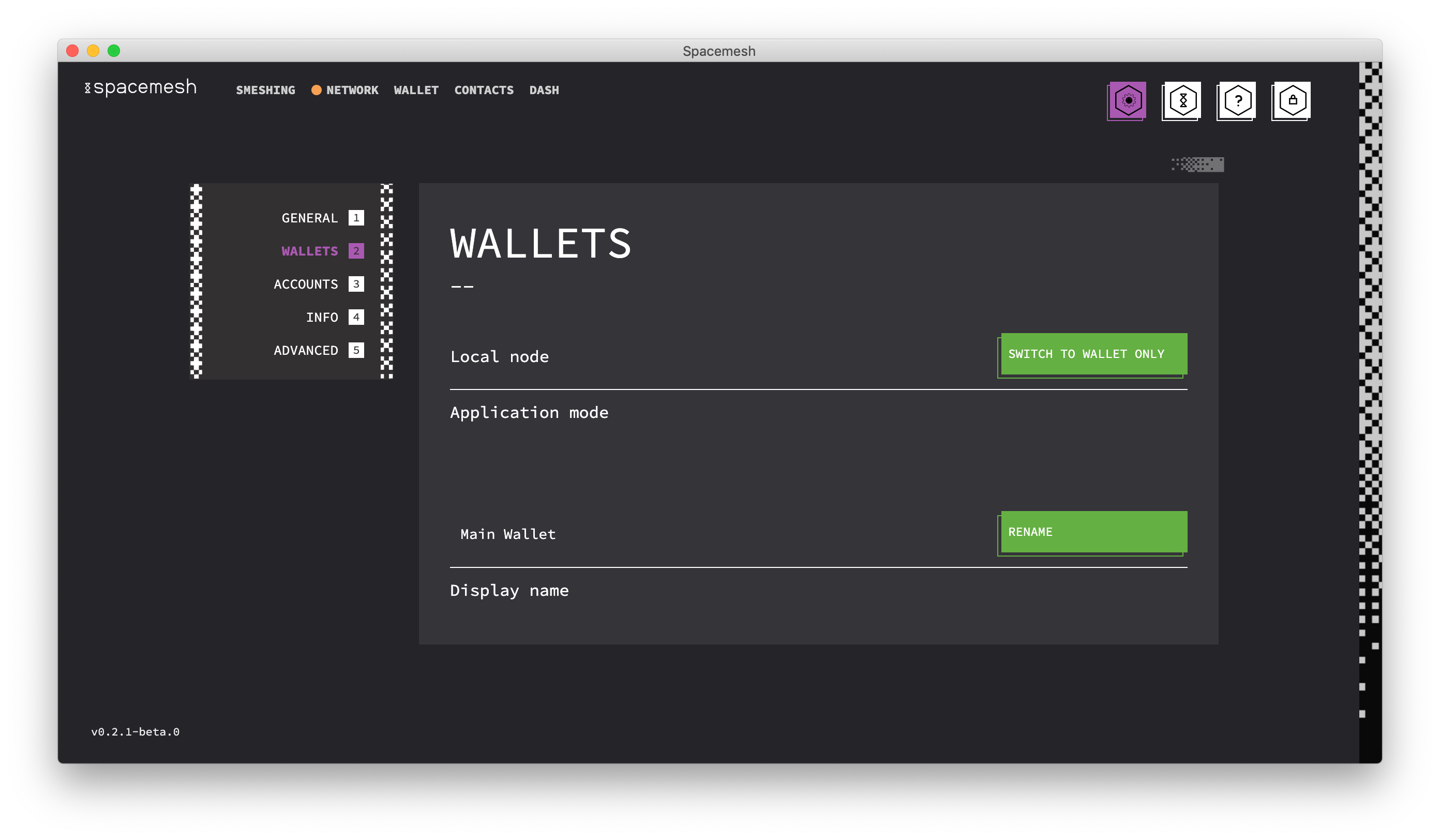

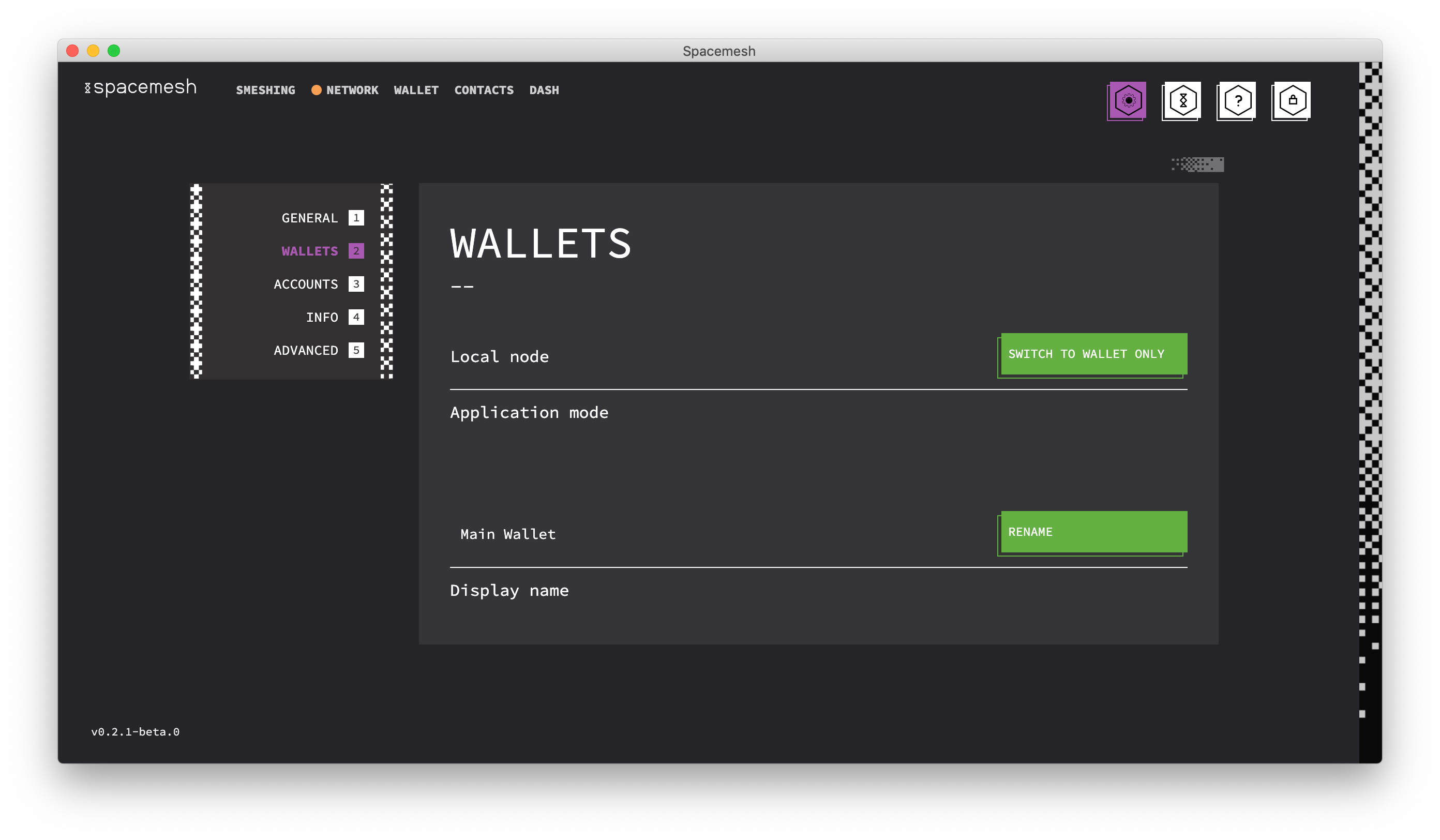

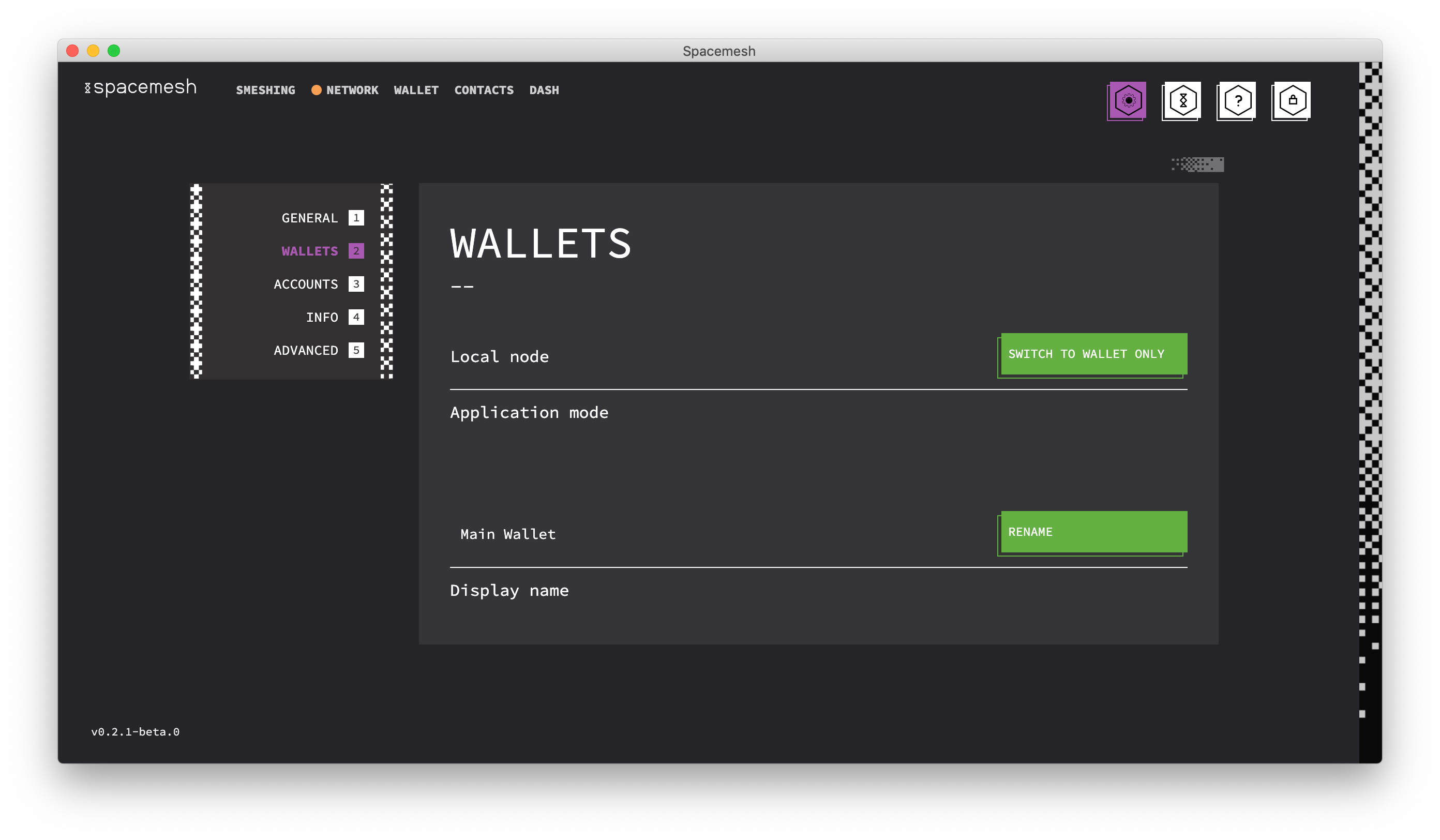

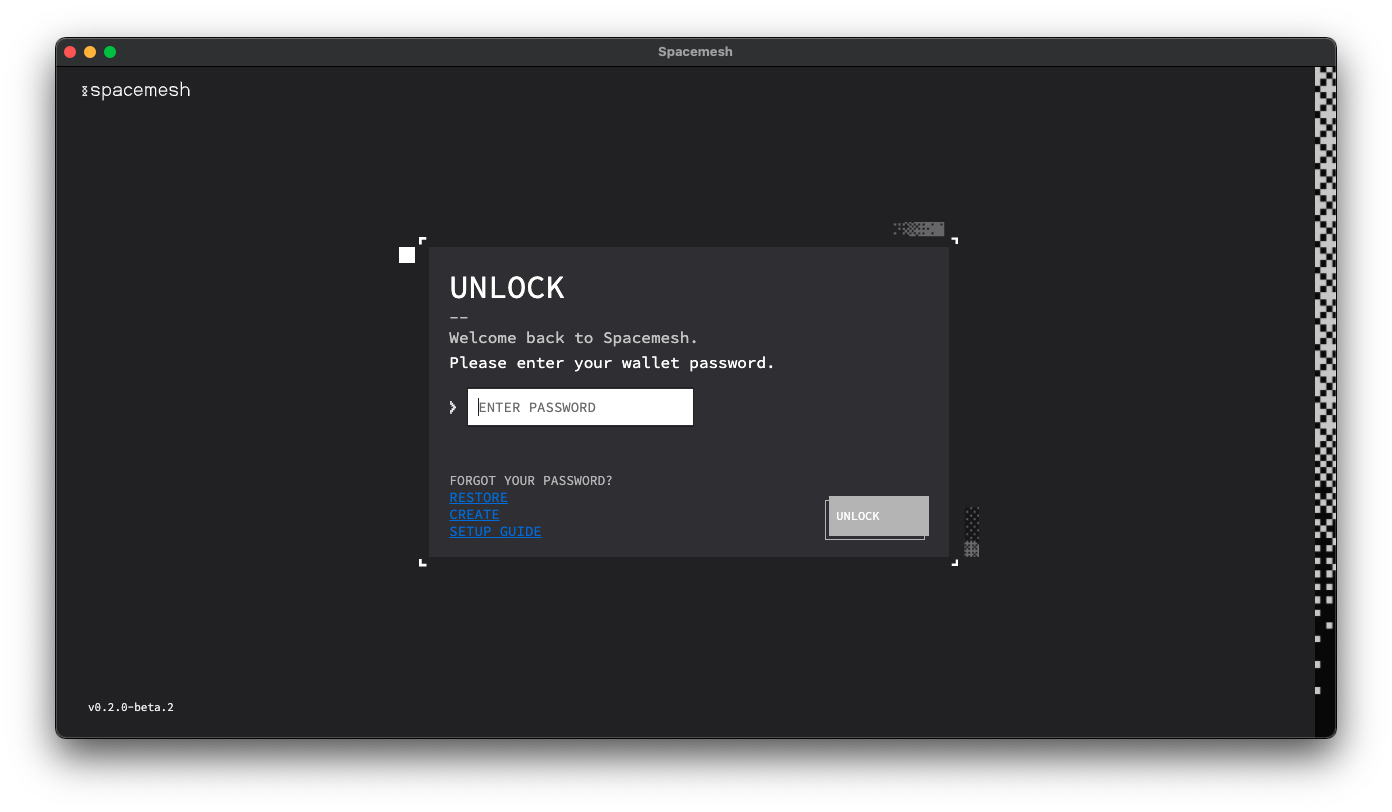

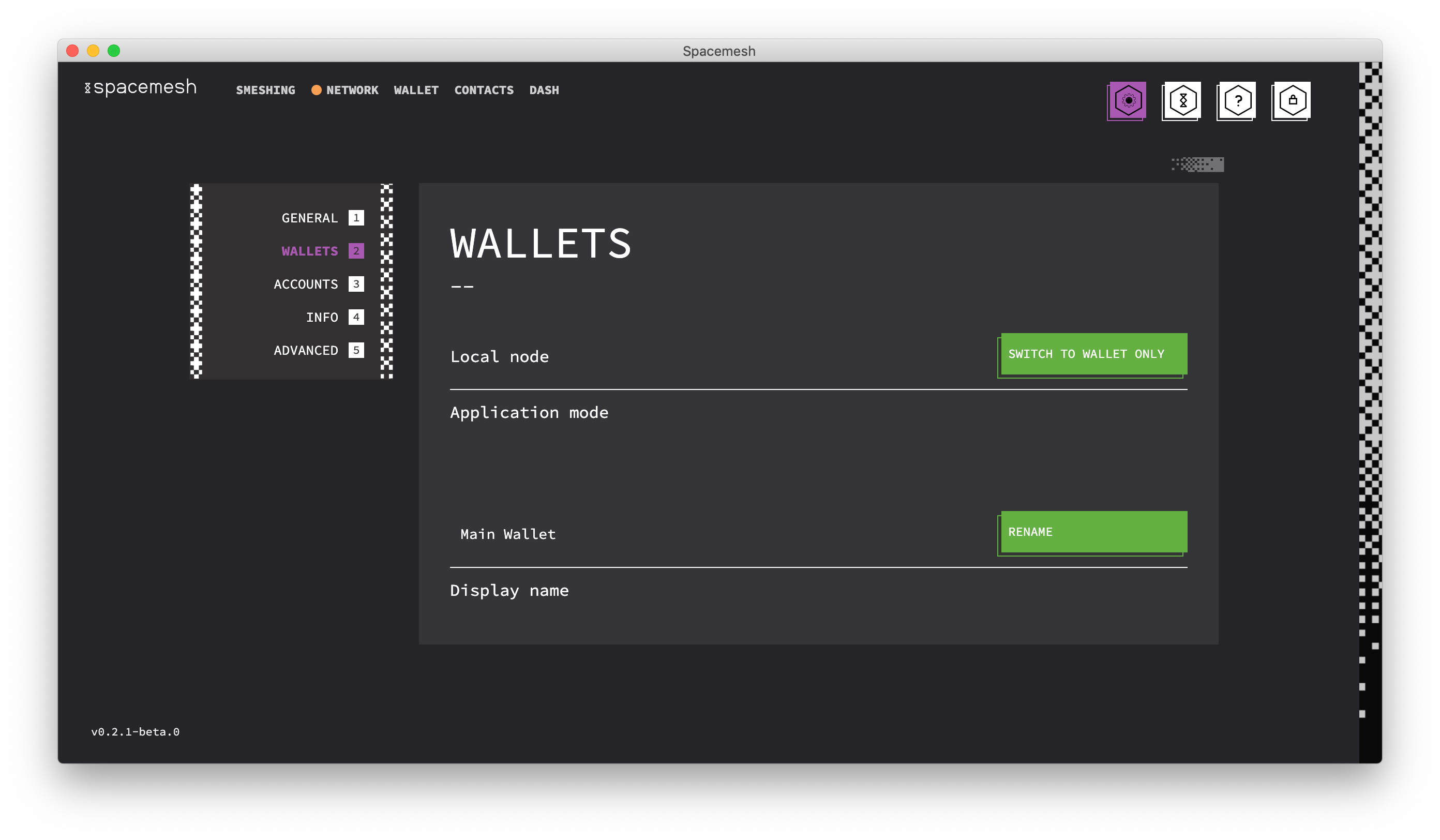

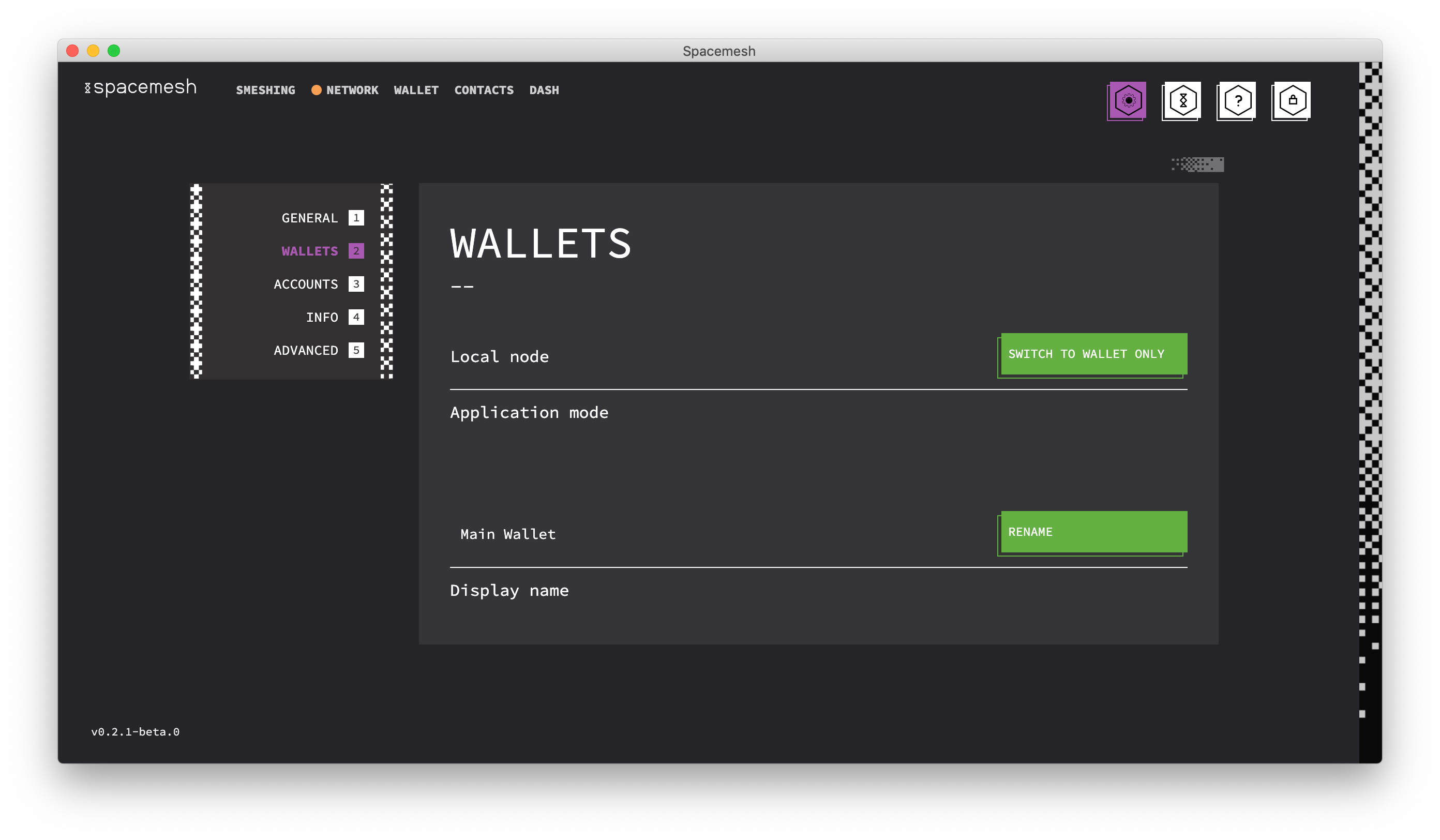

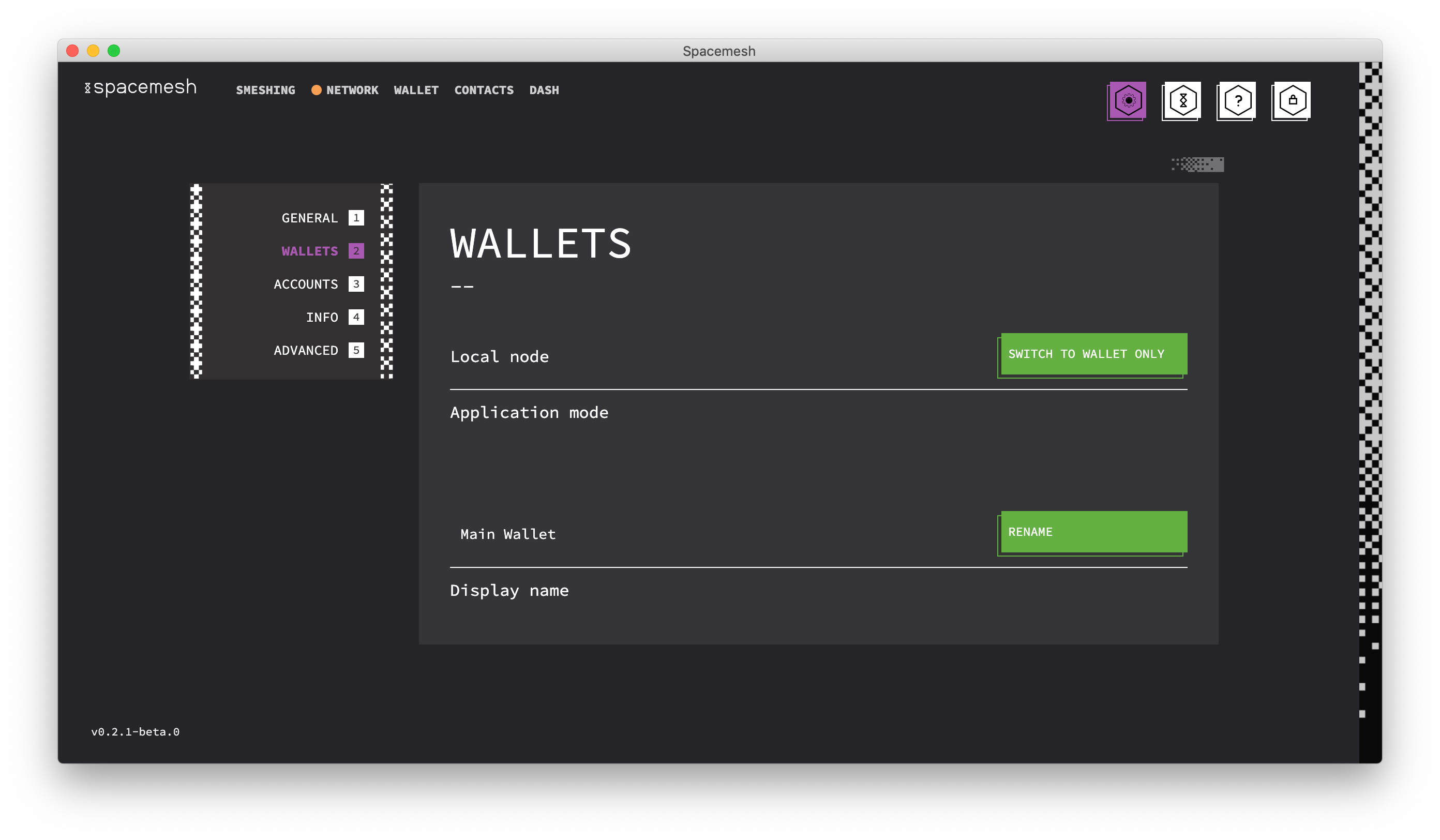

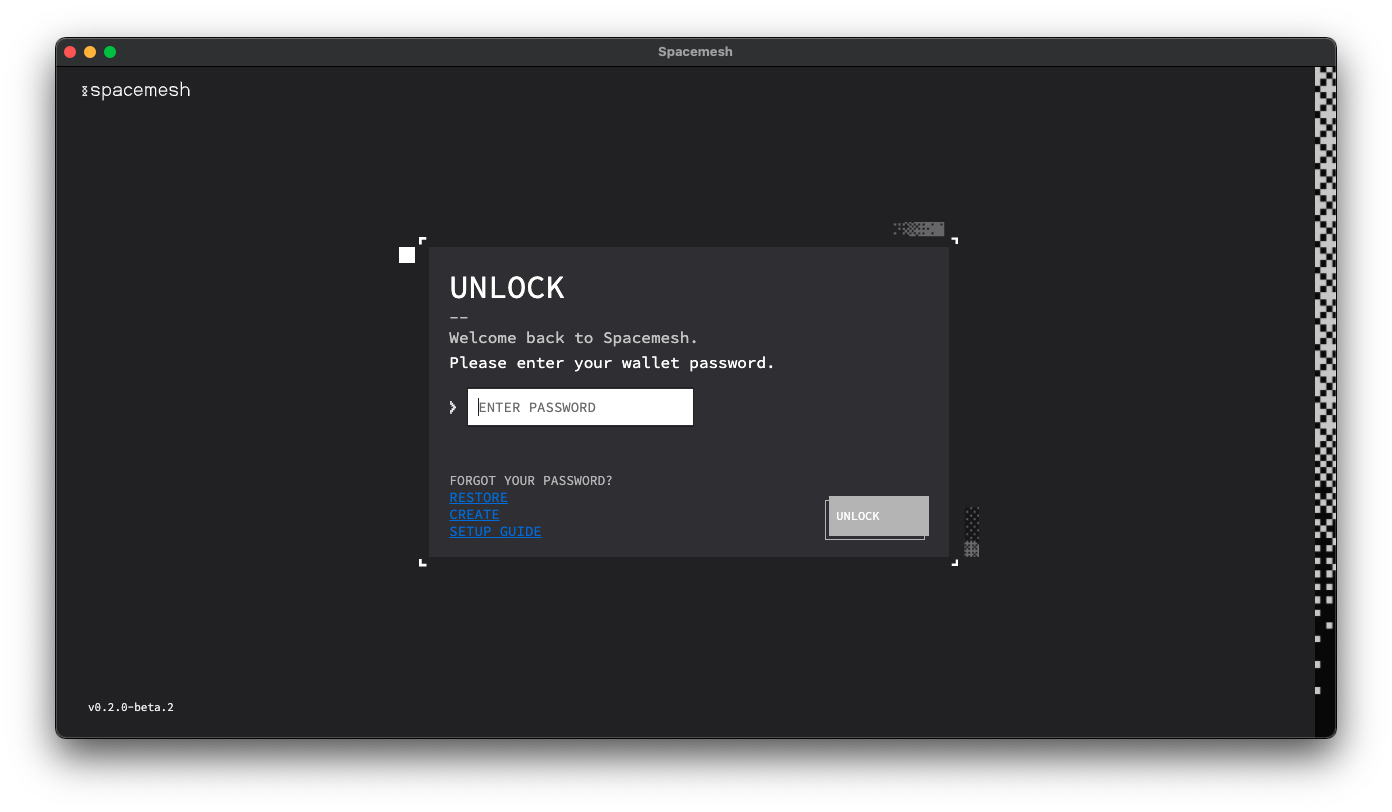

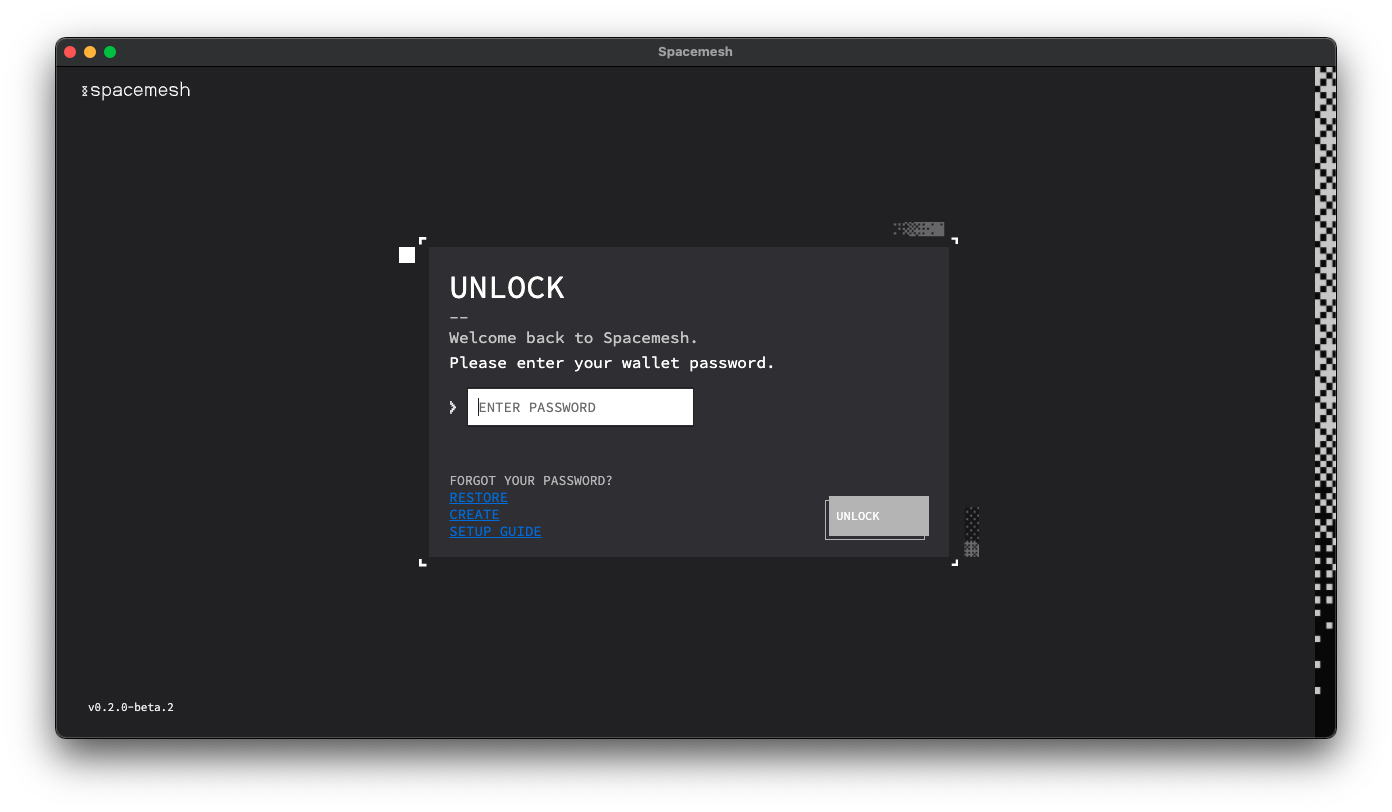

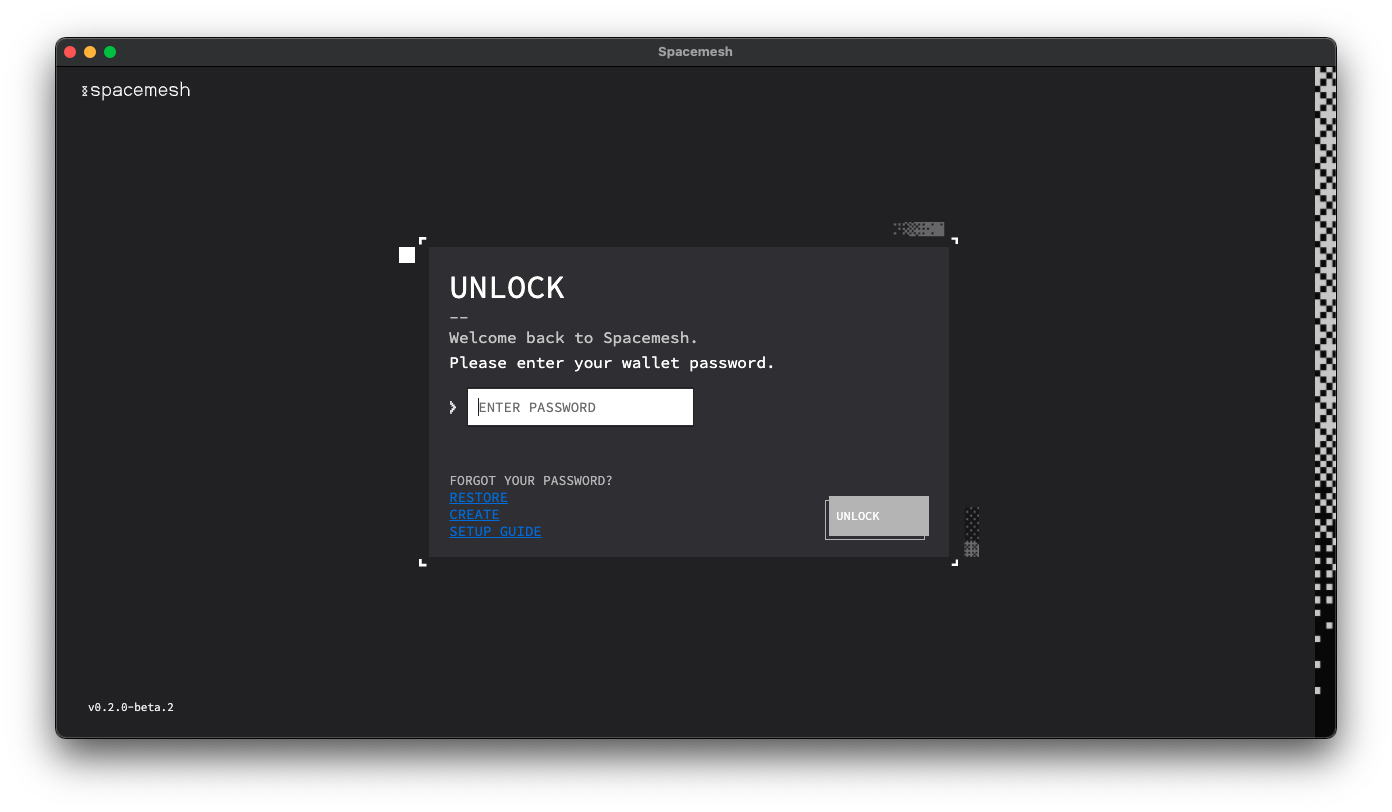

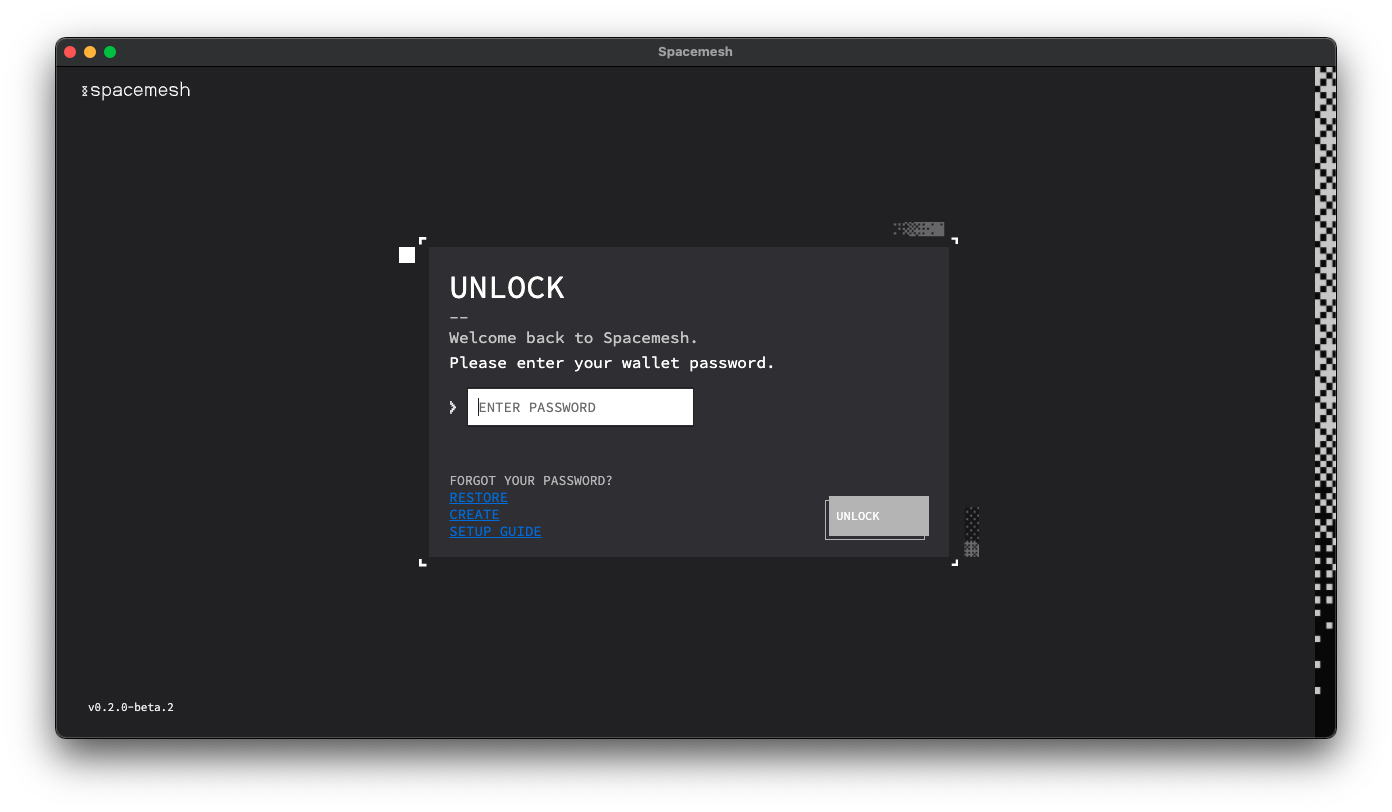

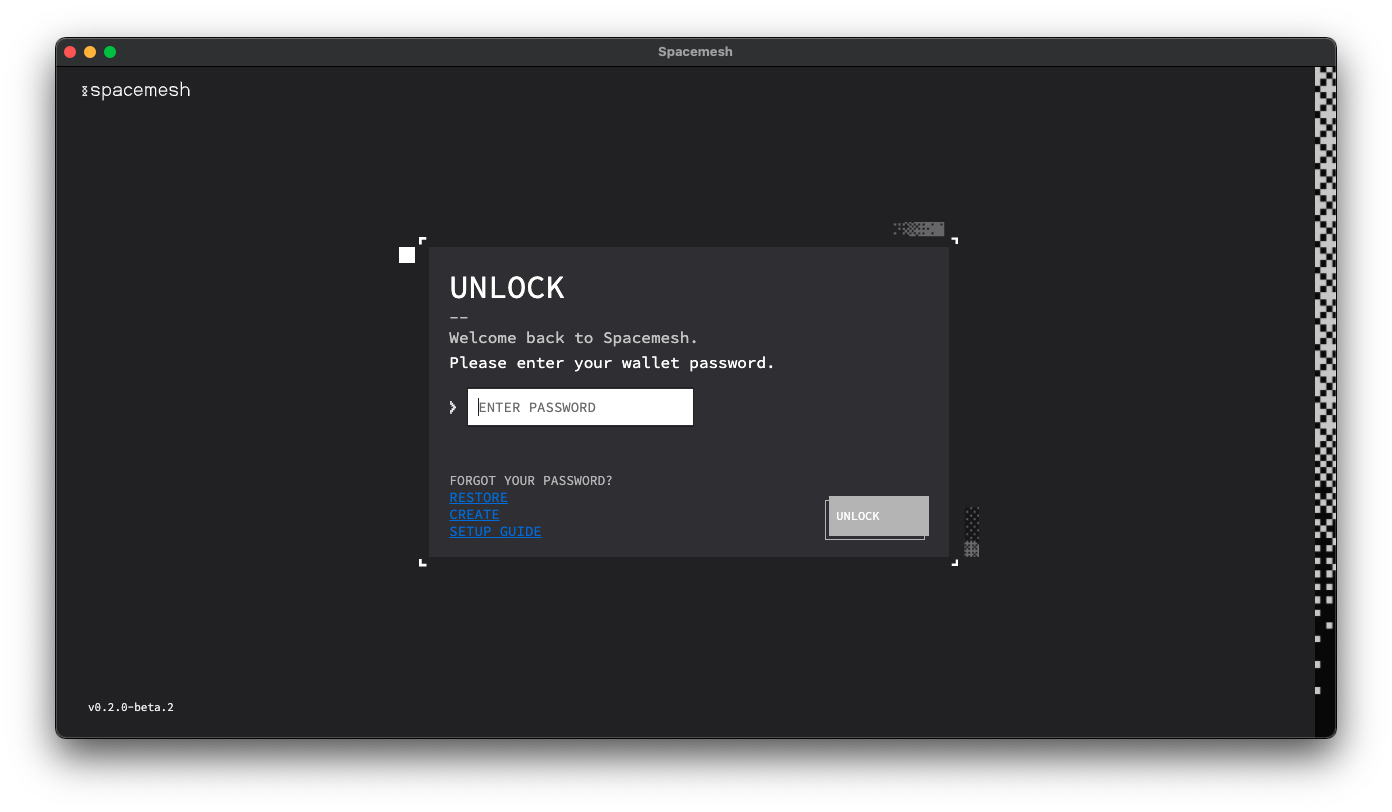

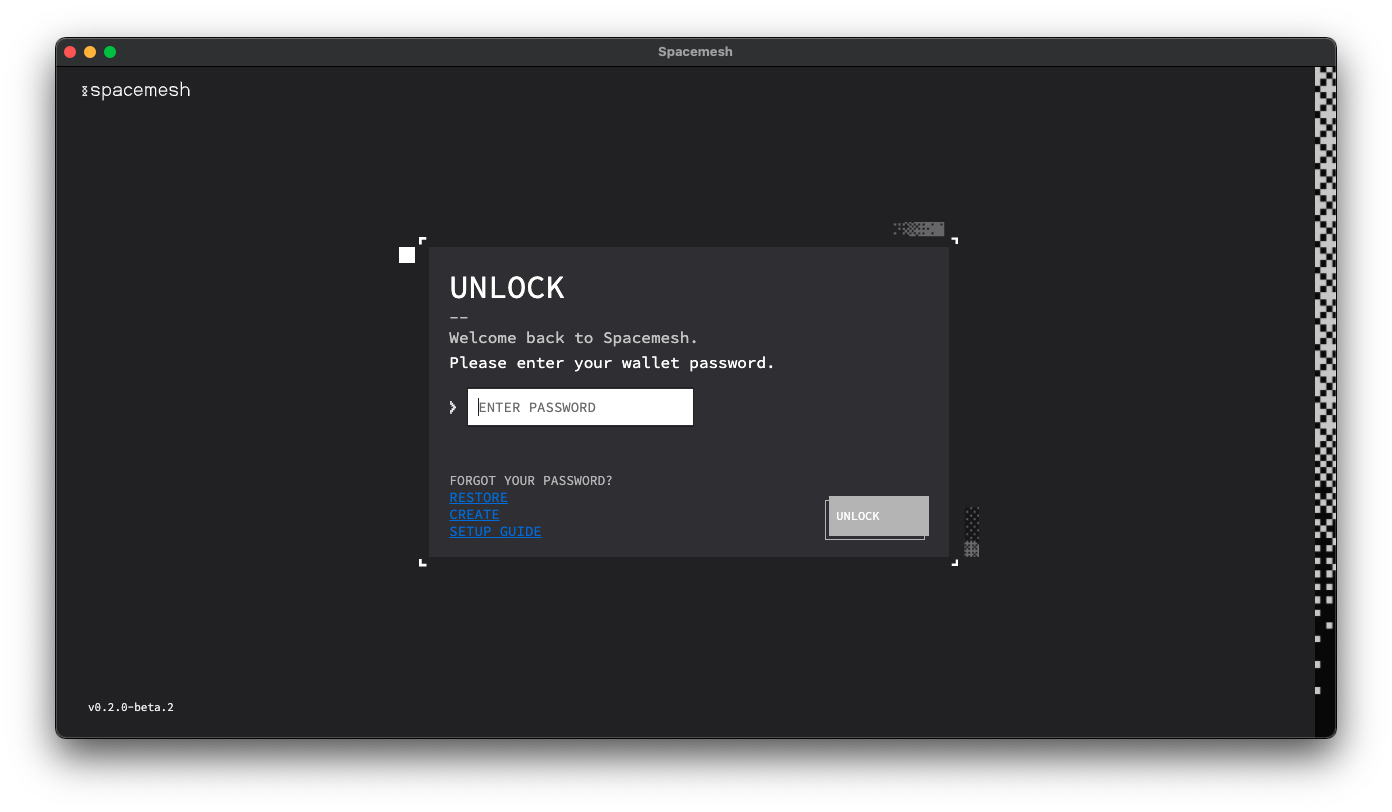

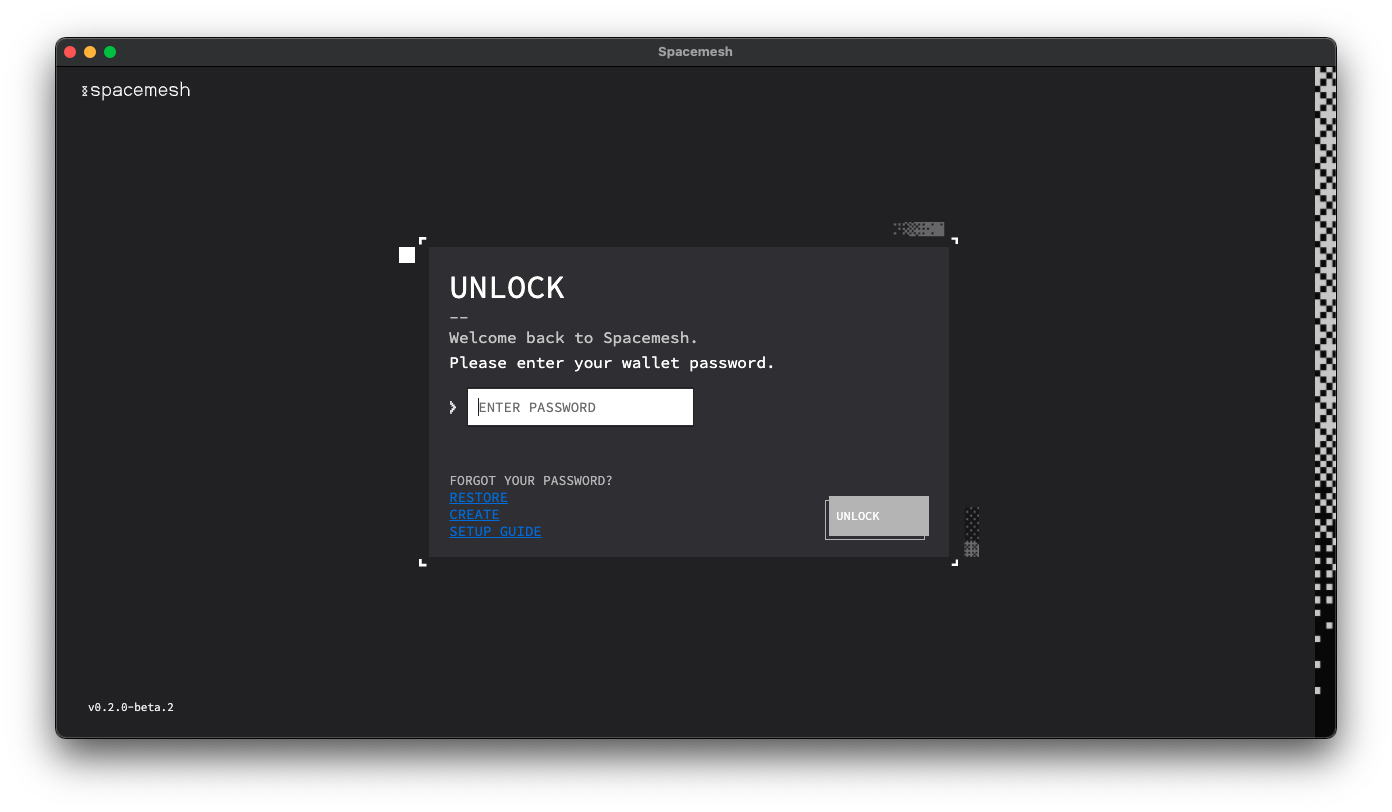

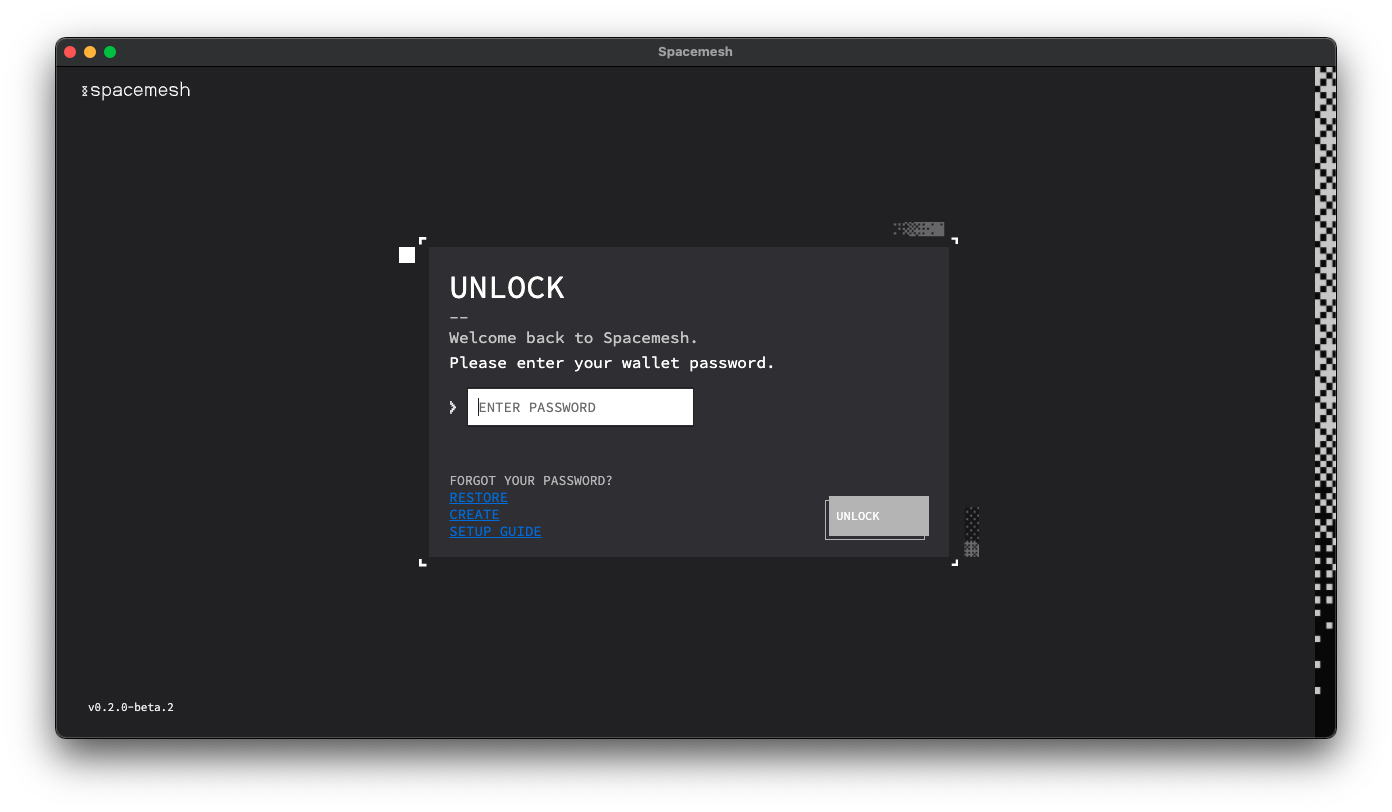

Unichain 测试网水龙头信息 Spacemesh切换到仅钱包模式

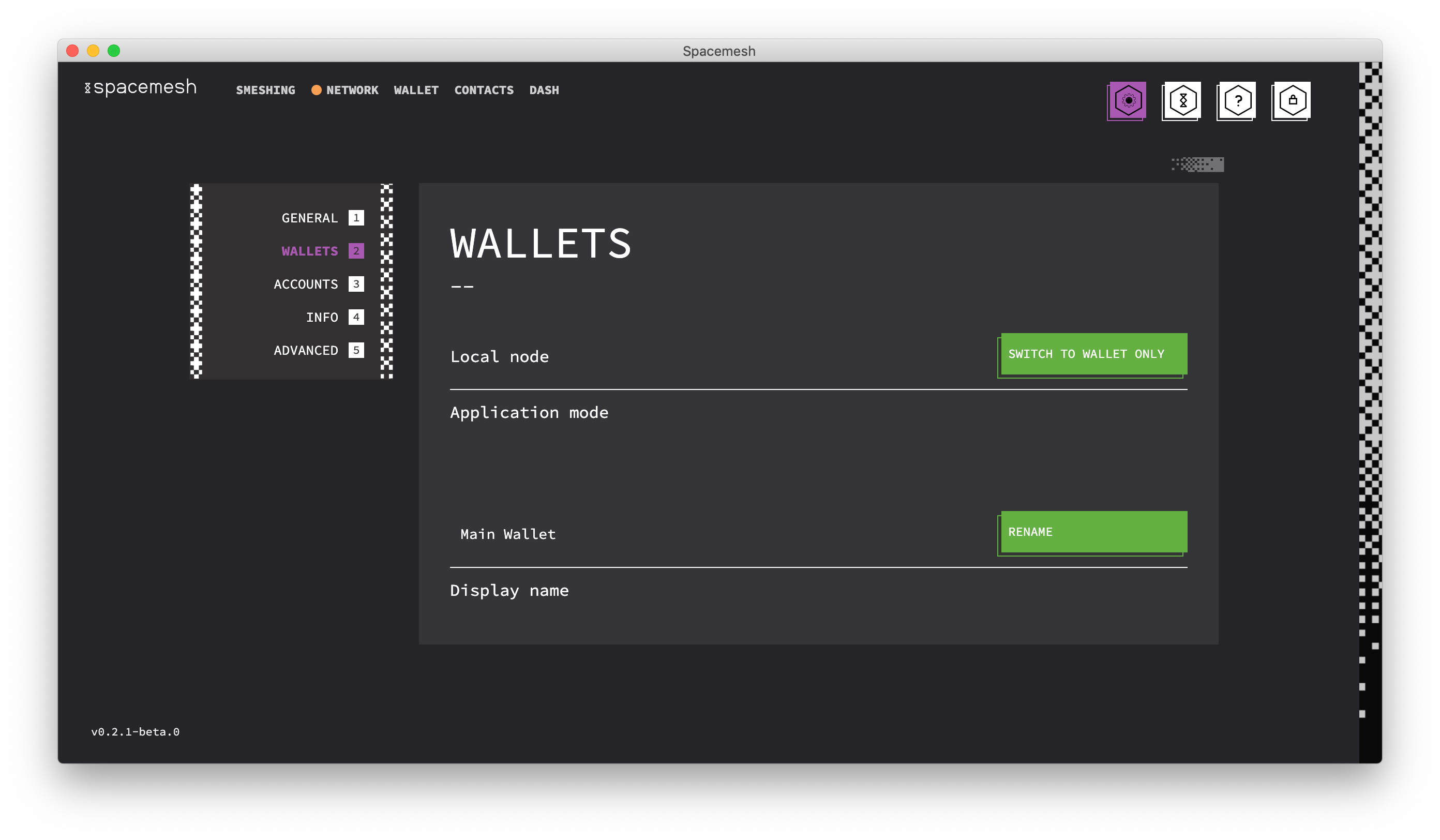

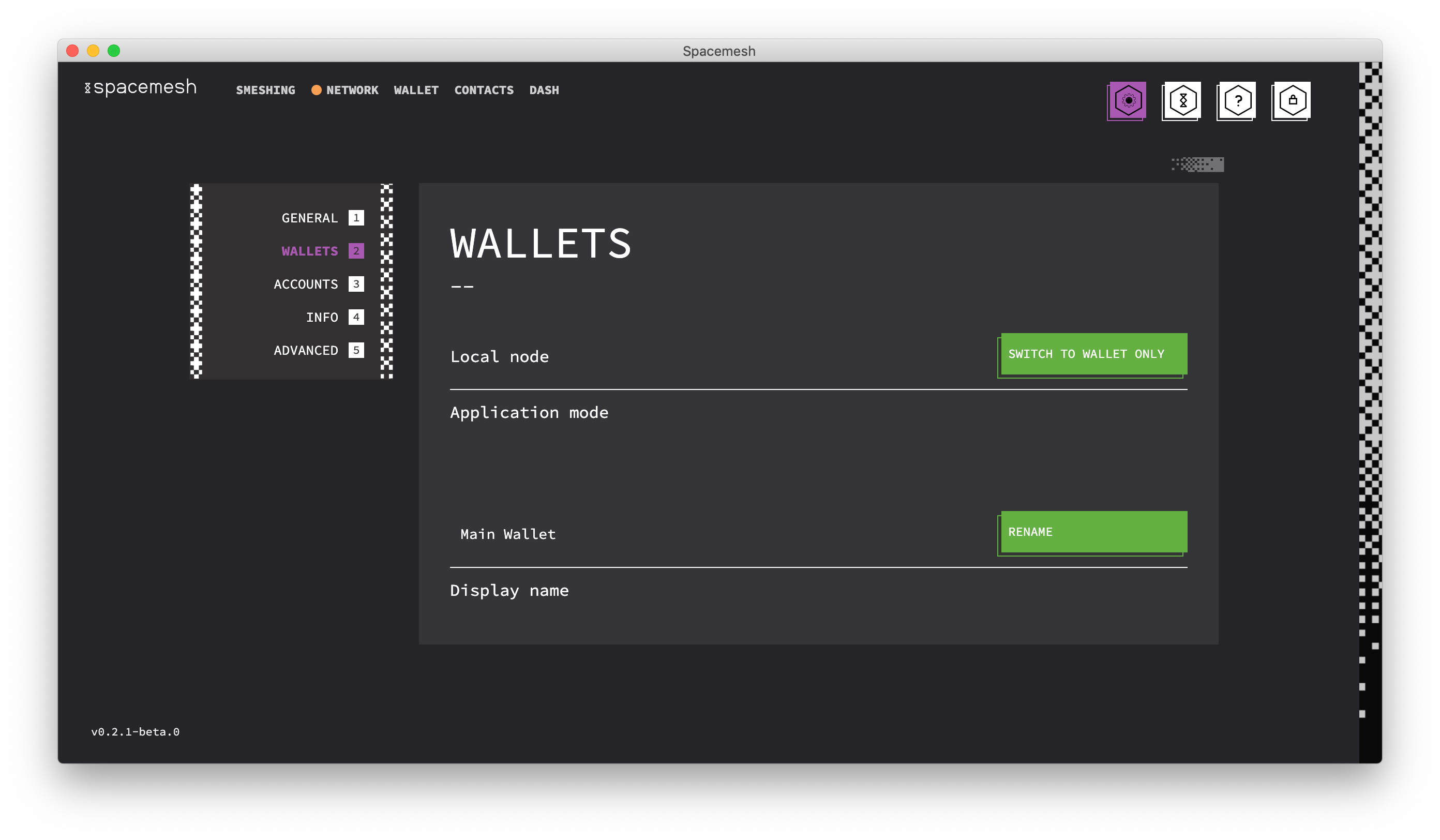

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 Spacemesh切换到仅钱包模式

Spacemesh切换到仅钱包模式 使用Spacemesh钱包操作教程和使用方法

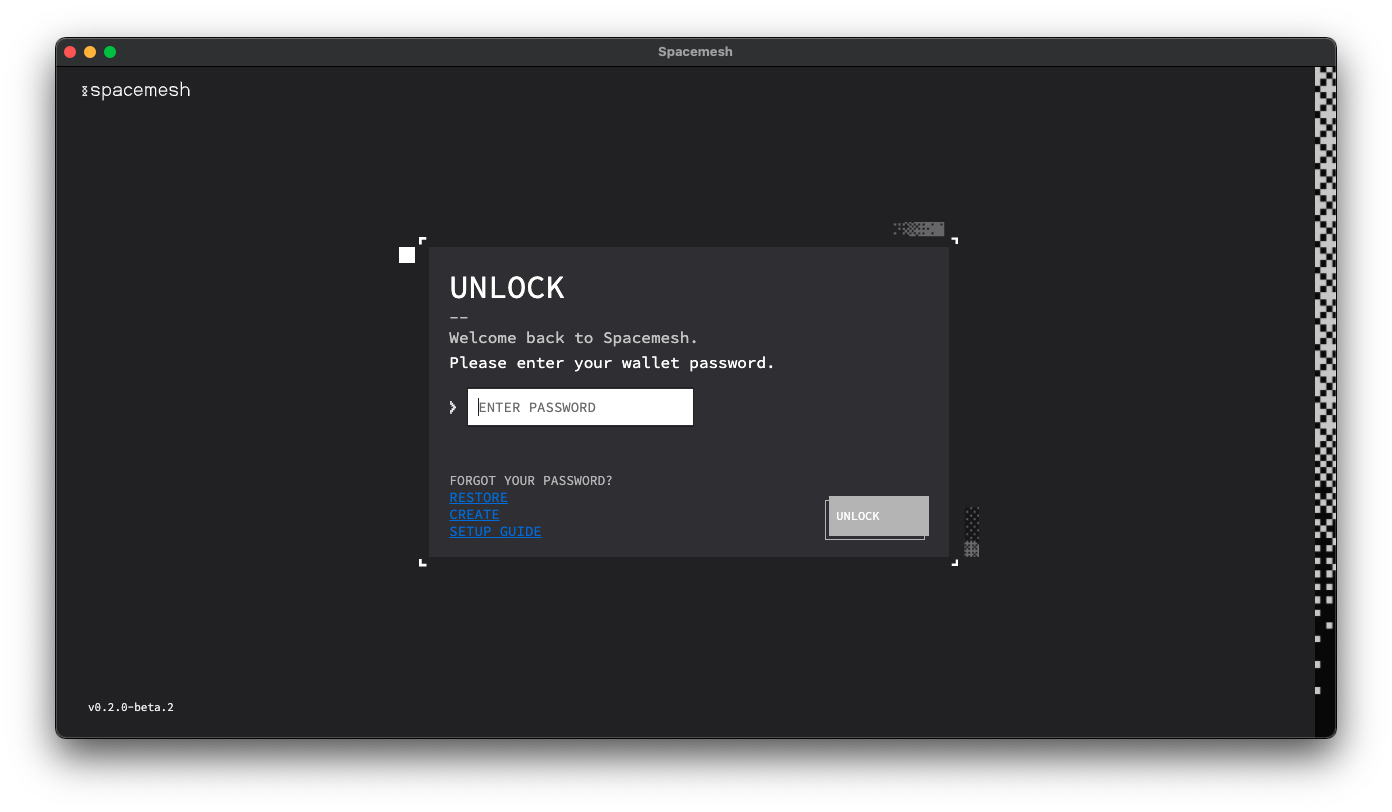

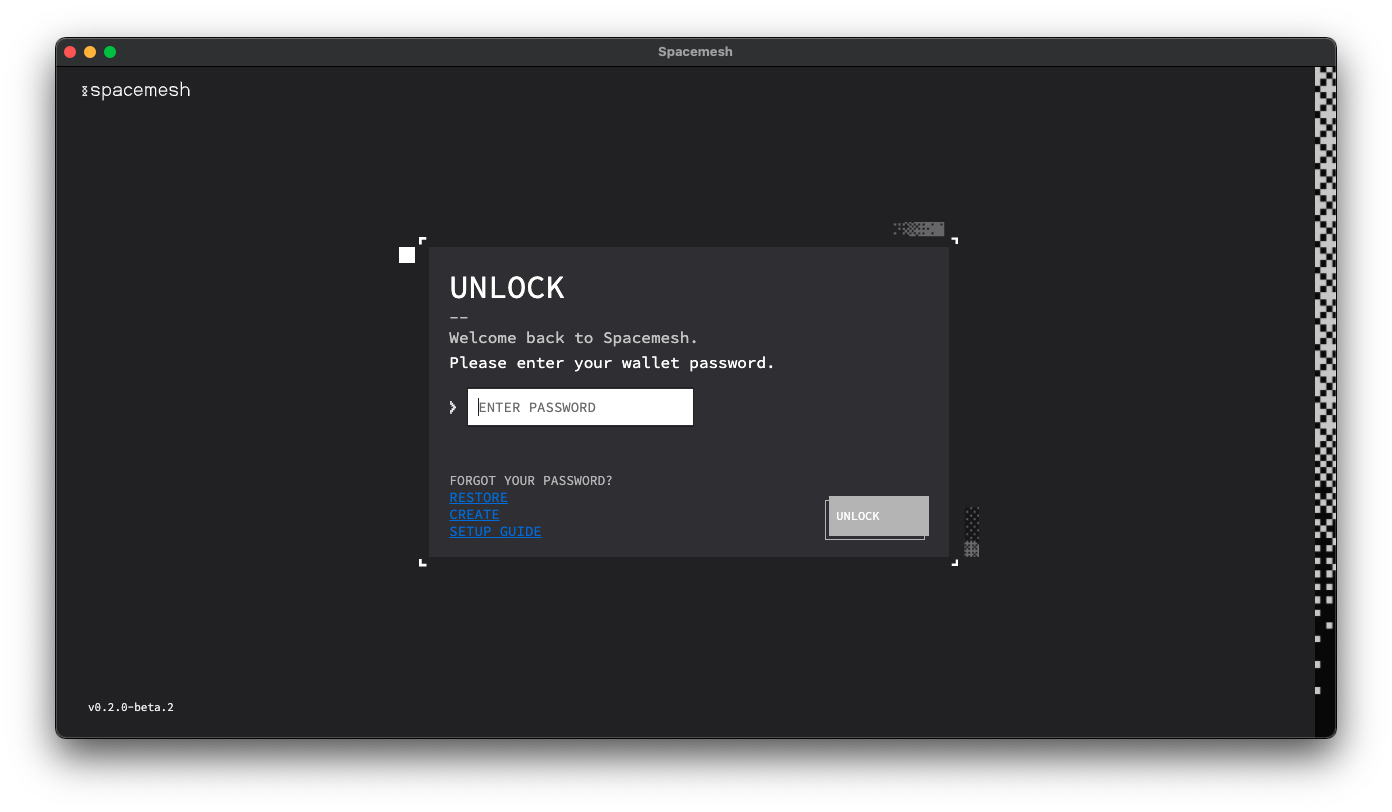

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法 使用Spacemesh钱包操作教程和使用方法

使用Spacemesh钱包操作教程和使用方法